"DeepseekR1671B"搜索结果 1 条

"DeepseekR1671B"搜索结果 1 条

本地部署DeepseekR1671B模型需要什么配置?

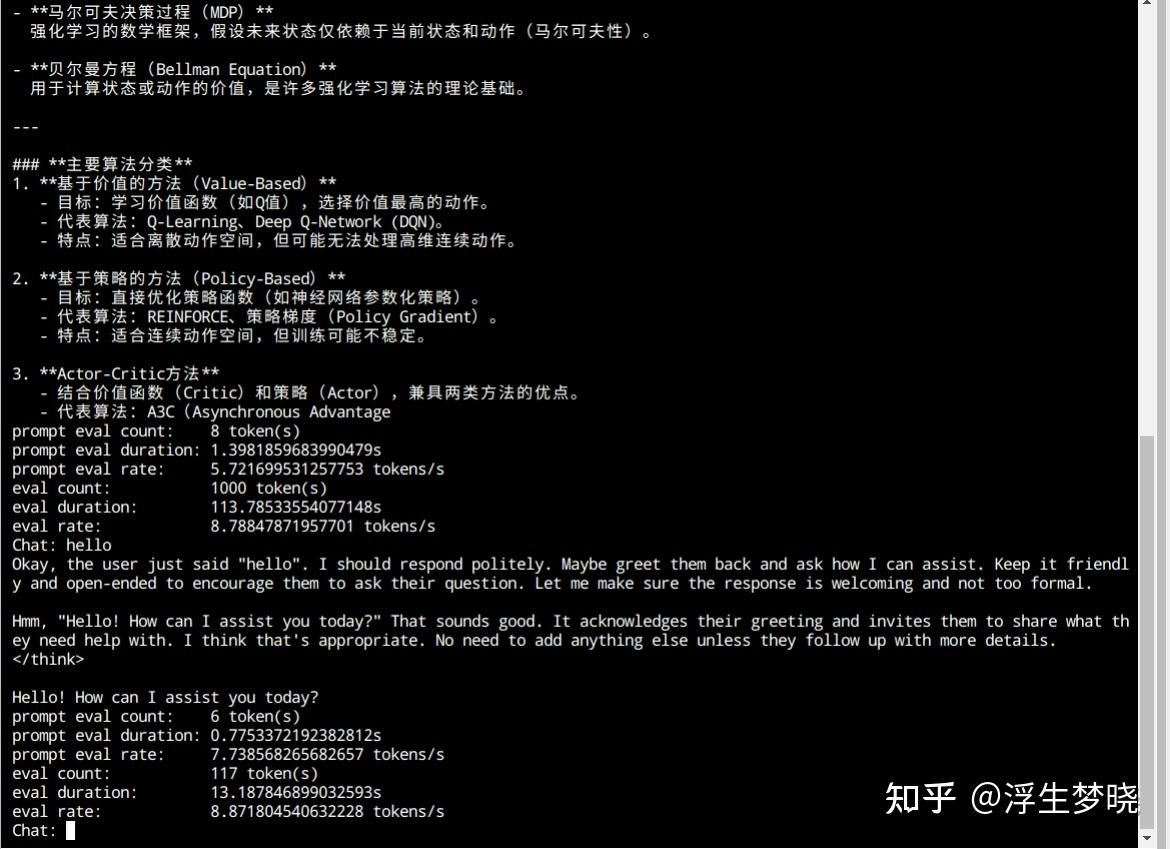

今天下午用ktransformers在4090上跑了下R1的4bit量化版本,模型大小370多G,按照框架要求需要380多G的CPU内存,直接在autodl上开的4张卡,实际推理只用了一张卡,过程很顺利,就是速度着实慢,官方decode是12token/s,我跑的实际上8token/s,可能CPU比较差吧。 这个框架底层用的是llama.cpp,外接的python接口,之所以这么快是因为英特尔CPU指令集更好的调用内存,再就是只讲激活的专家放到GPU上。 个人使用也能接受,就是380G内…