"Llama"搜索结果 2 条

"Llama"搜索结果 2 条

如何看待 Llama 3.1 ?

近日,英伟达开源了大语言模型Nemotron-70B,在多个基准测试中,这个基于Llama 3.1训练的模型超越了GPT-4o和Claude 3.5 Sonnet这些最先进AI模型。 一如既往,硅基流动SiliconCloud第一时间上线了Llama-3.1-Nemotron-70B-Instruct。 感受一下Llama-3.1-Nemotron-70B-Instruct在SiliconCloud上推理加速后的效果。 Playground传送门(需实名认证) https://cloud.siliconflow.cn/playground/chat/17885302599 API文档 https://docs.siliconflow.cn/api-reference/chat-completions/chat-completions 与其他各类开源大模型一样,开发…

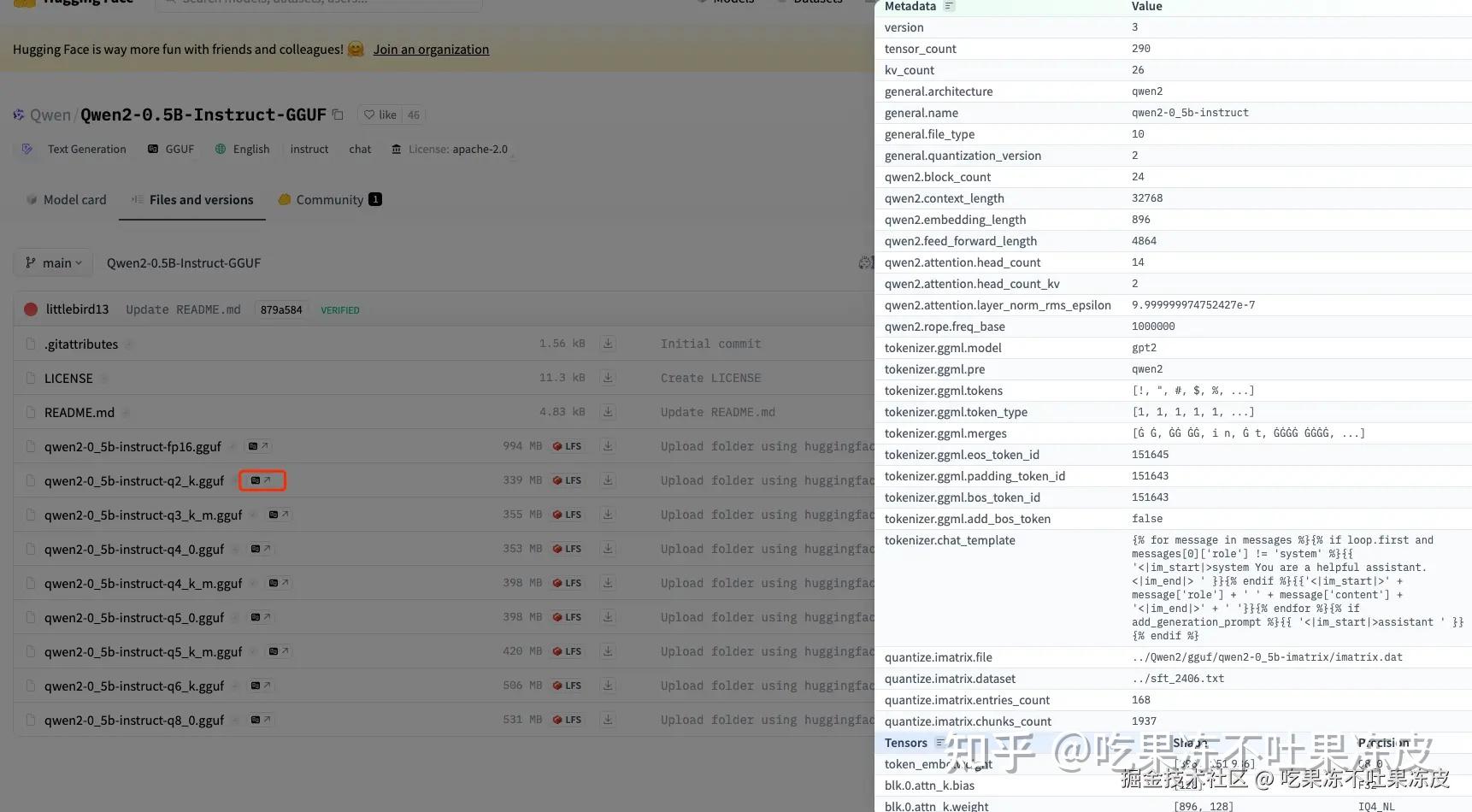

LLaMA 的GGML和GGUF区别是什么?

在日常AI模型训练过程中,训练好的模型权重通常需要以一种格式存储在磁盘中。比如:目前最流行的AI框架 PyTorch 使用 pickle 格式存储模型权重文件,还有 Huggingface 提出的 Safetensors 格式。之前在 一文详解模型权重存储新格式 Safetensors 中讲述Safetensors,本文大介绍大模型文件存储格式新宠GGUF,目前 Huggingface Transformers 已经支持了GGUF格式,同时,像谷歌的Gemma、阿里的Qwen等模型默认已经提供了GGUF格式文件…