为什么用 DeepSeek 总是提示「服务器繁忙」?怎么解决?

折腾了两天,我把网上那些号称能用 DeepSeek-R1-满血版的方法都跑了一遍,从官网到第三方平台,从 API 到本地部署,全都试了个遍。

真要说起来,有些平台是真的好用,但也有些平台挺让人迷惑的。

特别整理了一下,这篇文章基本上把目前能免费使用真满血版 R1 的渠道都收集全了。

全文字数8000+,预计阅读时间20分钟,建议先收藏阅读!

(注:本文只探讨基础对话功能的R1渠道,像coze、飞书这些接入DeepSeek-R1的功能性平台不在探讨之列)

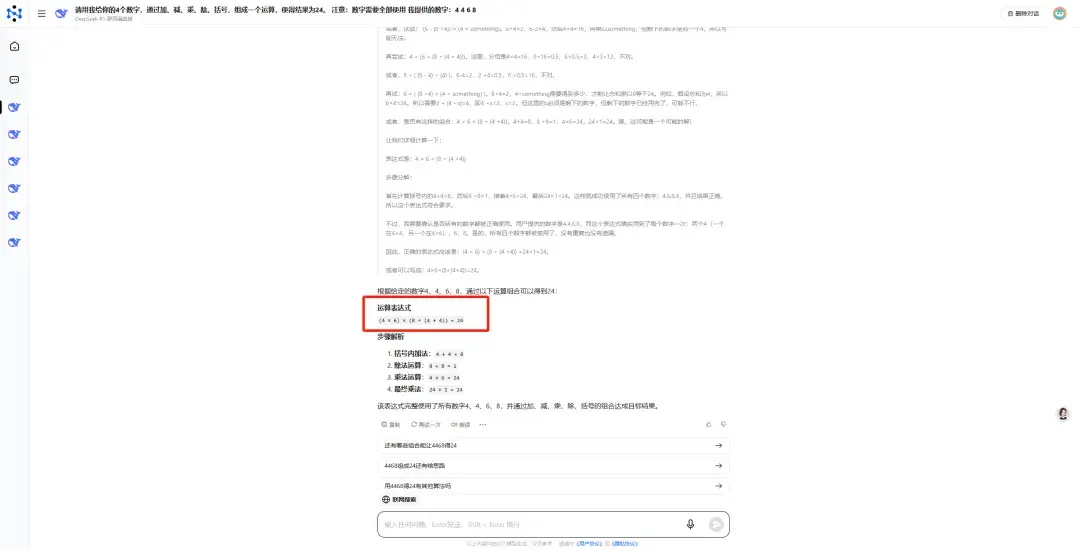

一、怎么判断是不是真R1-满血版

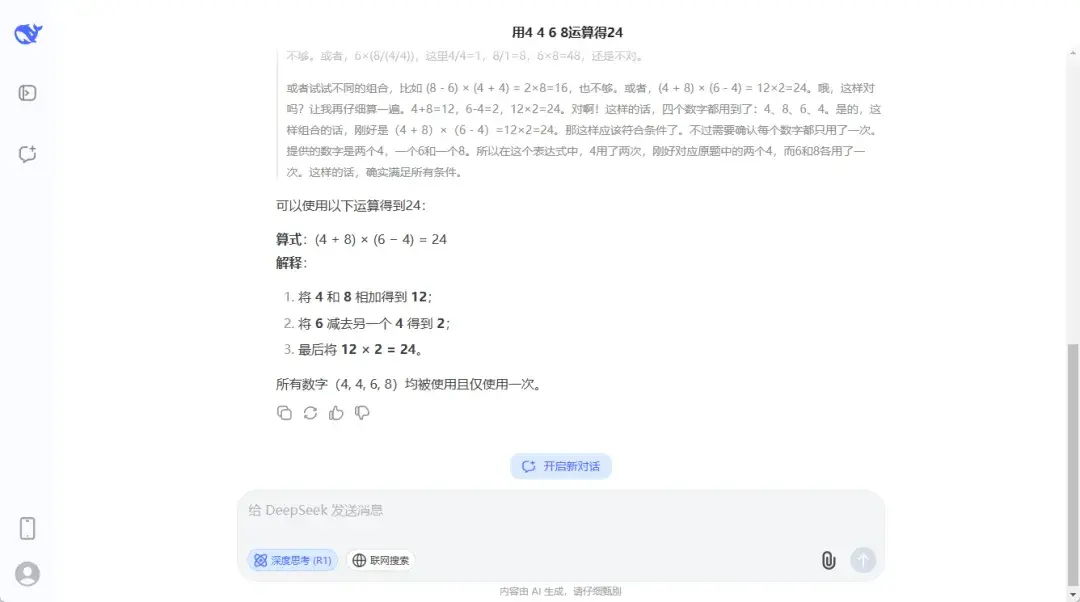

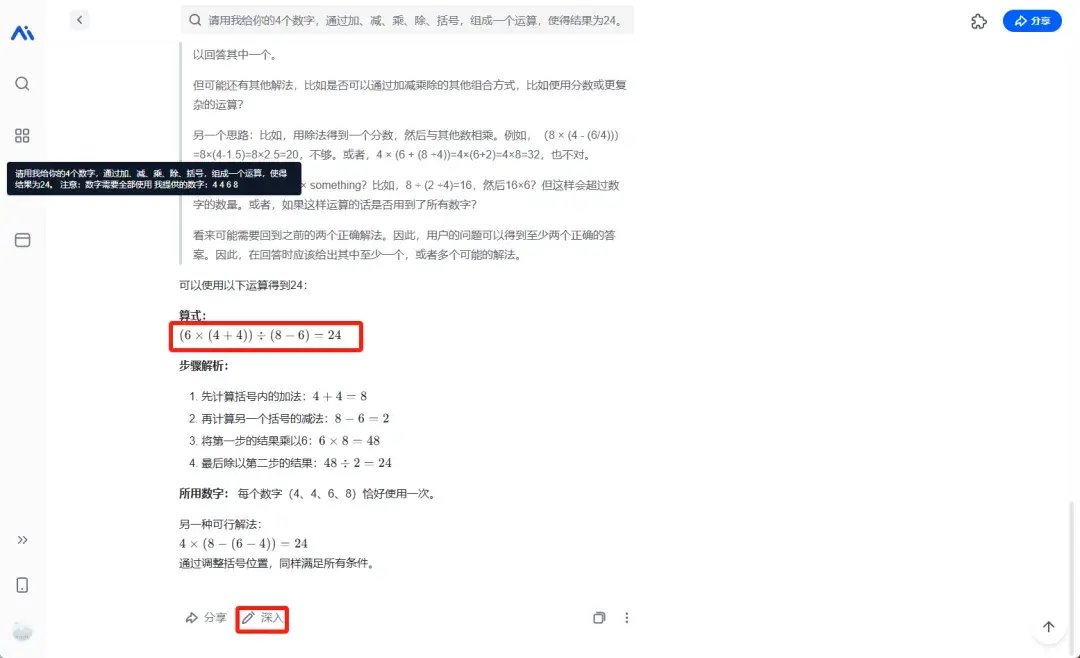

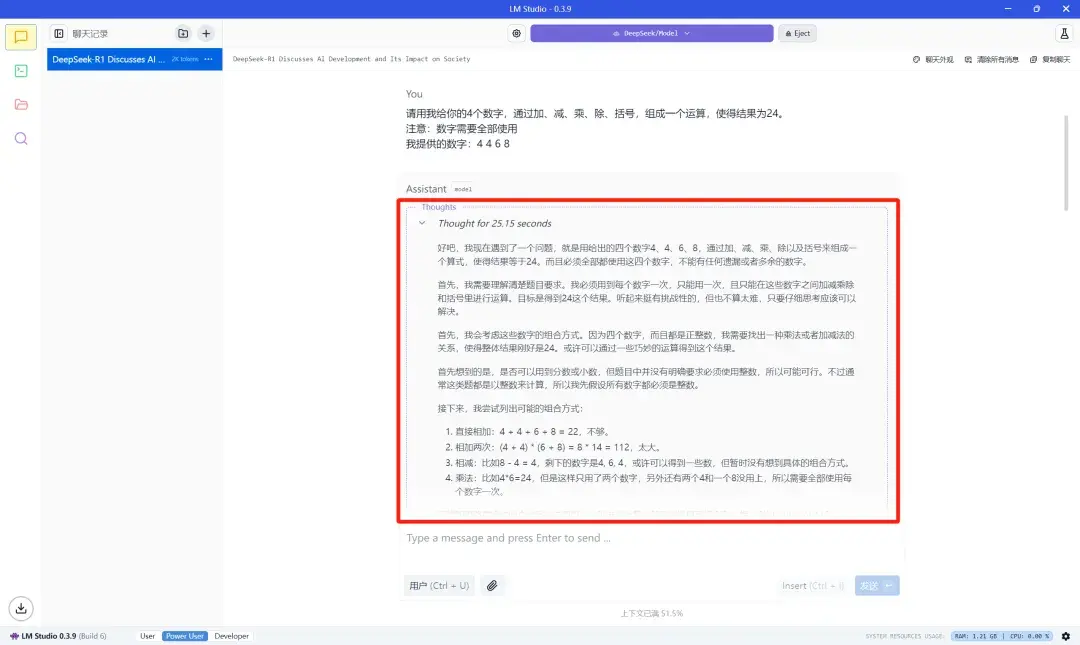

把这个问题发给DeepSeek:

请用我给你的4个数字,通过加、减、乘、除、括号,组成一个运算,使得结果为24。注意:数字需要全部使用我提供的数字:4 4 6 8

目前测试下来,只有满血版的R1可以稳定回答出来,满血版的V3版本偶尔可以回答出来,其余版本基本回答不出来。

(顺便提一嘴,目前这个问题测试下来只有满血版的R1和OpenAI的o1、o3-mini-high能够稳定回答正确,其余所有大模型要么完全回答错误,要么时对时错,不够稳定)

二、DeepSeek-R1-满血版使用渠道

1、官网+第三方网站

1)DeepSeek官网

网址:http://chat.deepseek.com

直接上官网或者下载官方APP是最靠谱的用法了。

记得用的时候一定要把"深度思考(R1)"这个模式打开,不然就跑的是V3模型。

虽然就差一个版本,但这两个模型的差距可不是一般的大。

不过官网最近白天几乎处于持续崩溃的状态……

深度思考模式下,短时间内连续提问两次大概率就会直接报错,而间隔二三十分钟左右提问第二次几乎不会报错。

我有理由怀疑官网为了缓解服务器压力对用户加了使用限制,几十分钟只能回答一次。

如果大家一定要使用官网的话,可以挑一些服务器压力没那么大的时候使用。

一般来说凌晨到早上八点前官网使用起来还是非常顺畅的,很少会出现问题。

不过随着热度慢慢降下来,加上官方修修补补,这些毛病应该用不了多久就能解决。

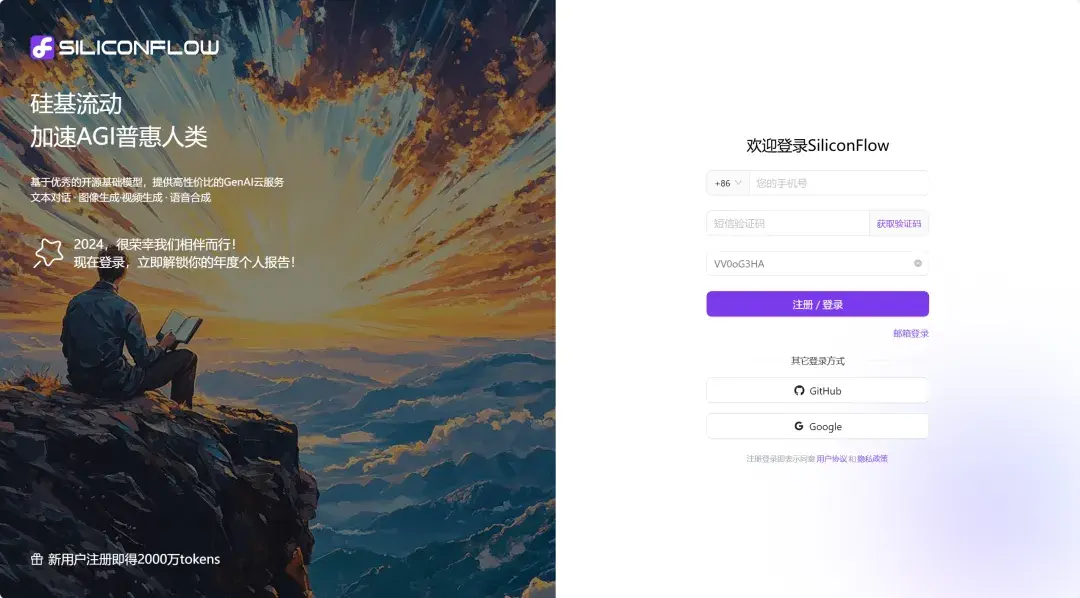

2)SiliconCloud(硅基流动)

网址:

https://cloud.siliconflow.cn/i/VV0oG3HA

国产大模型云服务平台SiliconCloud跟华为云、DeepSeek一起搞了个联动,上线了DeepSeek-V3和R1。

每个新用户可以获得2000万的tokens(约1万次对话),注册就能领。

用起来特别简单,打开SiliconCloud官网,手机号登一下就完事,非常方便。

登录之后就可以在主页看到排在第一位的就是DeepSeek-R1-满血版。

点击并选择在线体验就可以进入使用界面。

界面上有些参数可以调,但说实话默认设置就挺好,当然你要是想折腾也可以。

跟DeepSeek官网比,这边R1的效果差不多。就是这两天人也多起来了,尤其下午和晚上也会比较卡。

还有个不太方便的地方是看不了历史对话,生成内容的时候还不能跳转新页面。

不过考虑到人家主要是个云服务平台,这些小毛病也就别挑剔了,当个备用还是挺香的。

3)秘塔AI搜索

除了SiliconCloud之外,秘塔AI搜索也在自家平台上集成了DeepSeek-R1-满血版。

网址:

https://metaso.cn/

进入官网后,打开长思考·R1模式,就会自动调用DeepSeek-R1模型。

测试的效果和DeepSeek官网也没什么差别。

不过用起来感觉还是有点不一样。

因为秘塔主打搜索,所以用的时候会自动带搜索功能,就相当于在DeepSeek官网同时开了深度思考和联网搜索。

这样就有时候就会容易导致指令跑偏,更适合那种开放性的问题,精准任务就不太合适了。

另外使用R1的时候记得同时选择研究模式,可能是版本有一定差距,测试下来只有在研究模式下,DeepSeek-R1才能发挥出最大的性能。

非研究模式下,秘塔的R1不能够稳定回答出来测试问题:

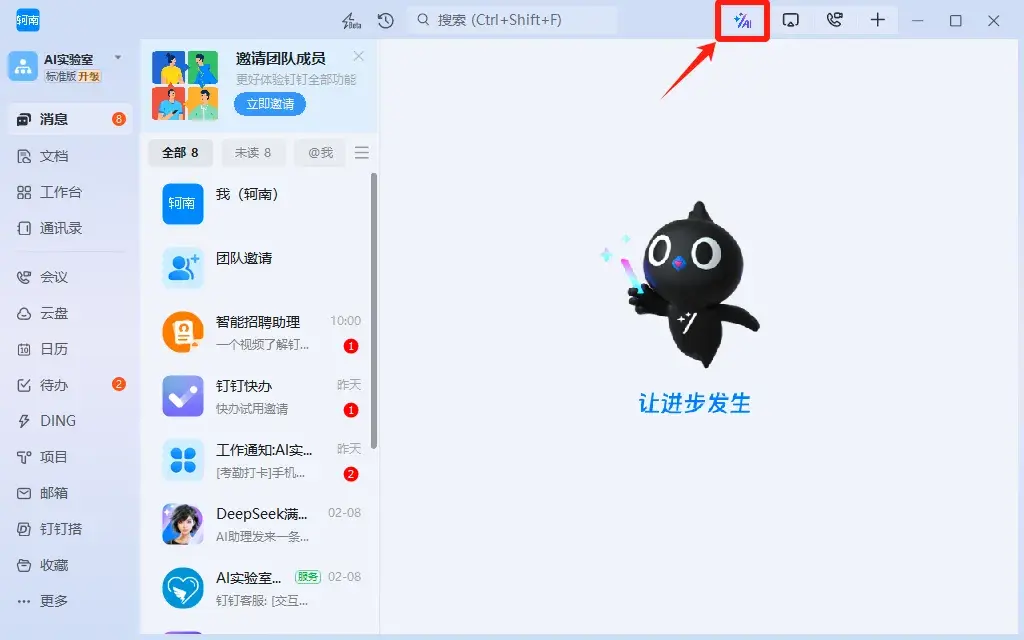

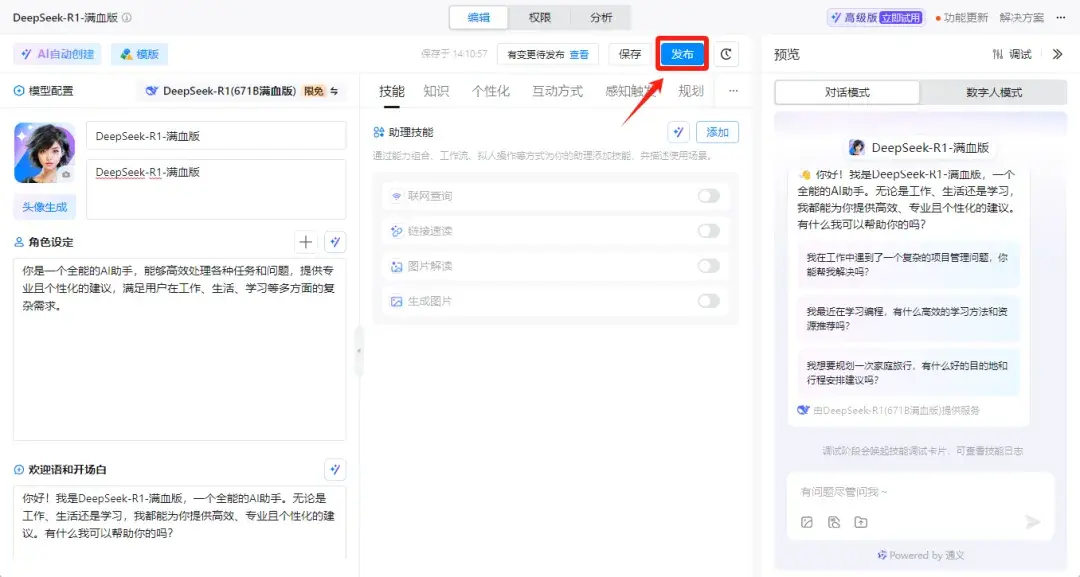

4)钉钉

打开钉钉(电脑客户端和手机APP操作流程基本一致):

确保你已经更新到最新版本的钉钉应用

创建AI助理:

在钉钉首页右上角找到“AI标记”选项,点击进入

点击AI助理:

点击“+”号创建AI助理:

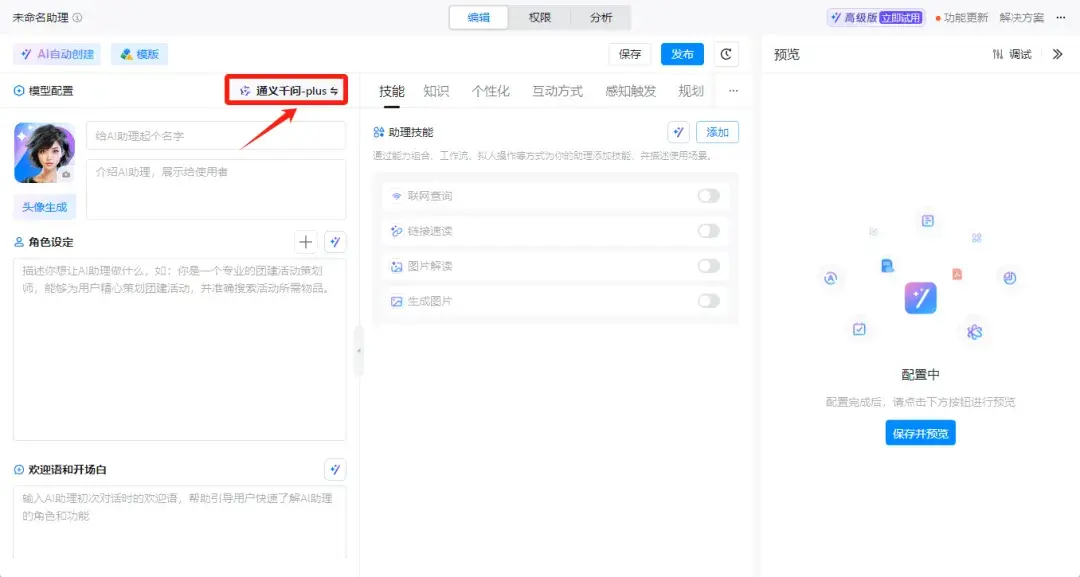

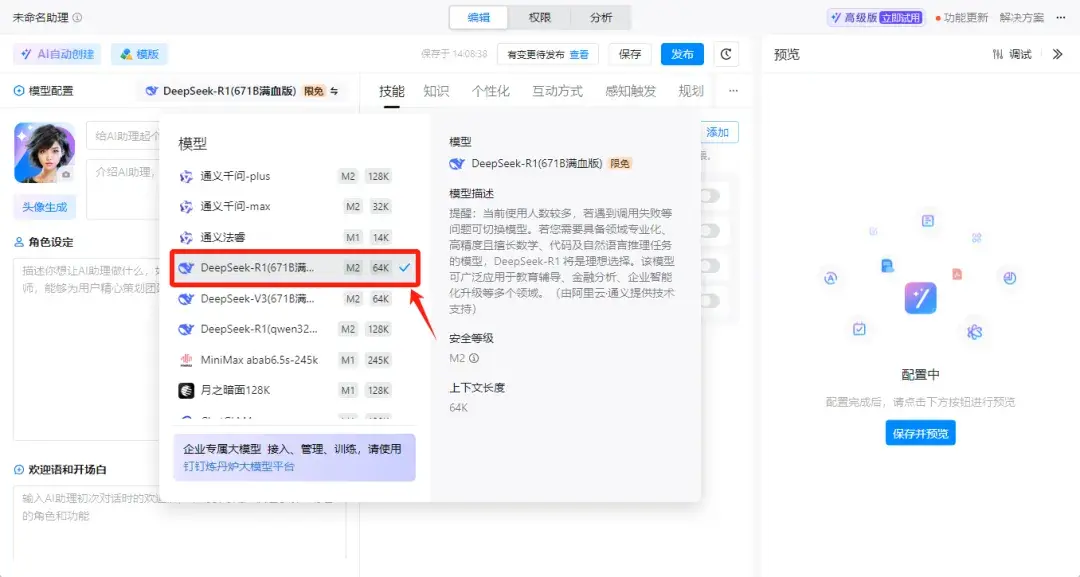

点击模型配置,选择DeepSeek-R1(671B满血版):

名称,角色设定和欢迎语这些直接自己随便填写或者使用AI生成就可以,然后点击发布:

选择仅自己使用并发布助理:

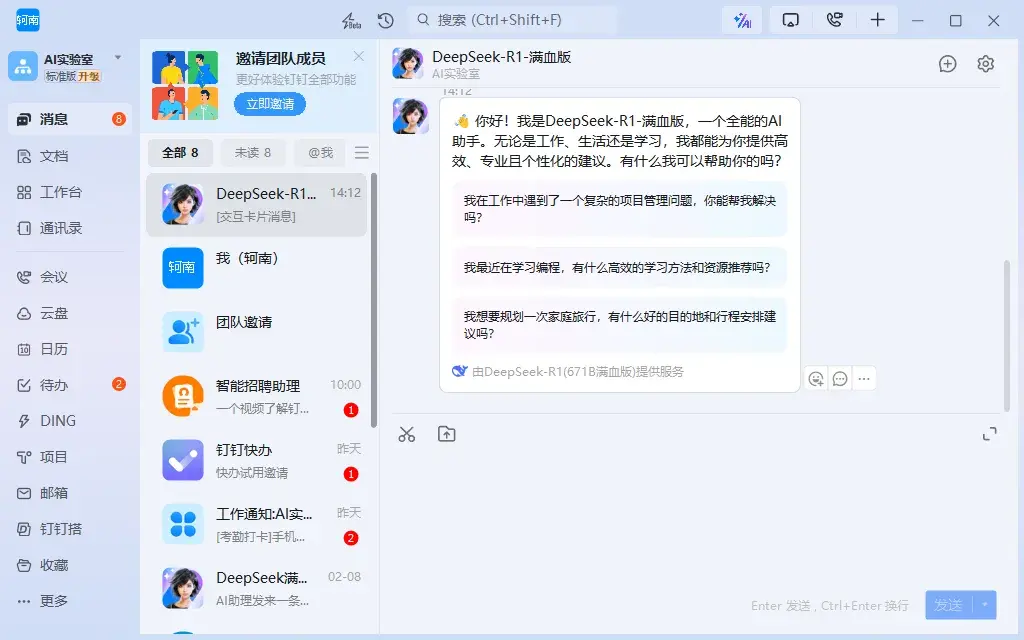

然后你就可以在对话界面找到刚刚搭建好的DeepSeek-R1-满血版了

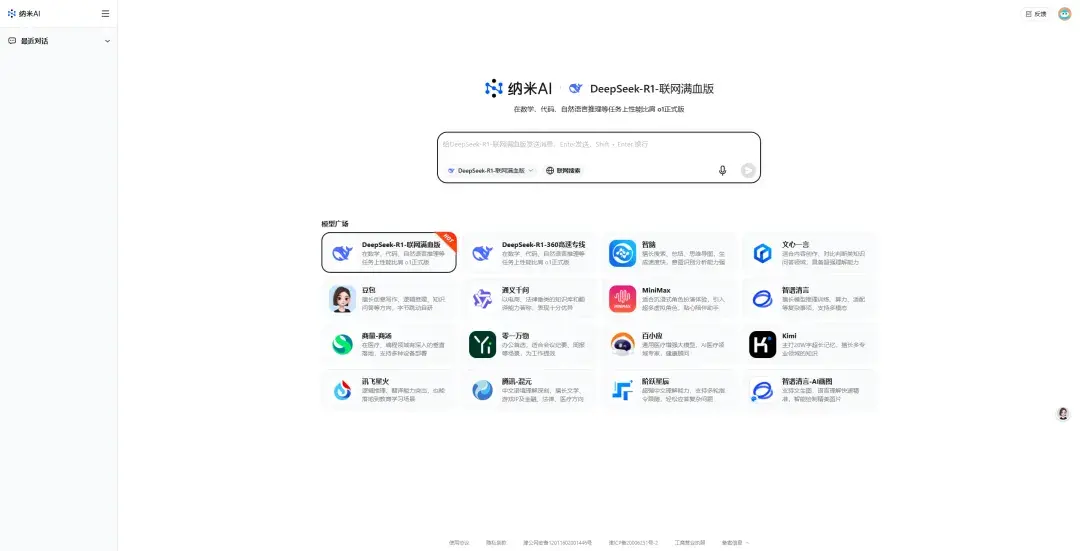

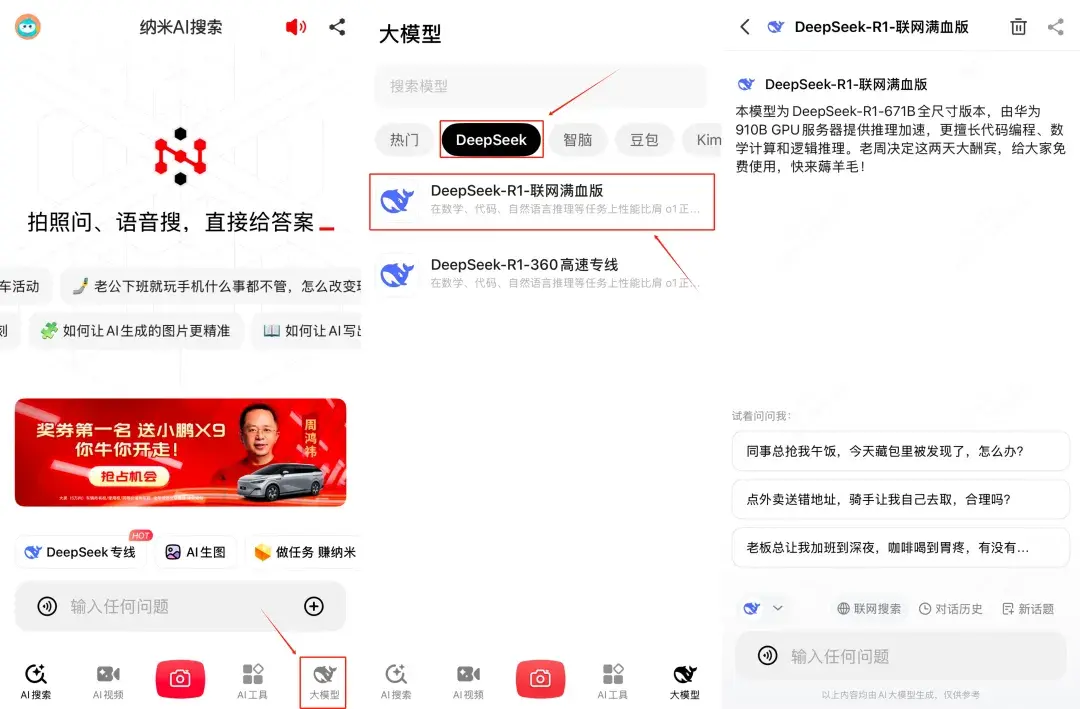

5)纳米AI搜索(存疑)

网页端使用方法:

网址:

https://bot.n.cn/chat

打开网址后,默认的模型就是DeepSeek-R1满血版,如果不是的话直接点击模型切换就可以用了:

记得一定要选择联网满血版,其它版本的DeepSeek-R1都不是671B的,性能差别很大。

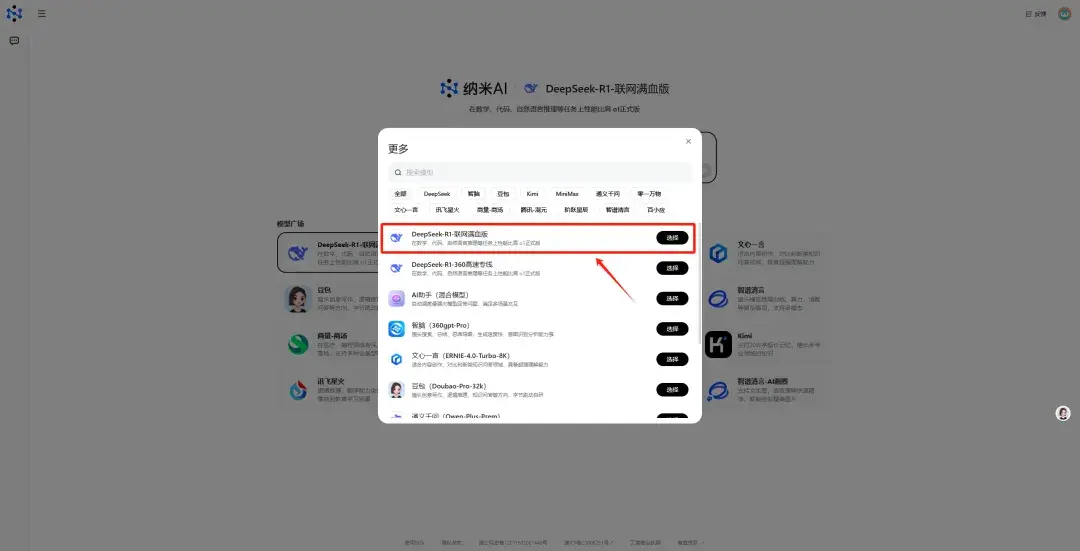

APP端使用方法:

应用商店下载纳米AI搜索APP:

进入纳米AI搜索后,点击右下角大模型:

选择DeepSeek栏 — 选择DeepSeek-R1-联网满血版

就可以直接使用了。

但是经过反复测试,我发现纳米AI搜索里的DeepSeek-R1-满血版可能存在一定程度上的弱化。

正常满血版R1可以稳定回答出来这个计算问题,纳米AI搜索里的R1却经常回答不上来,怀疑有可能掺杂了量化版本的R1,所以大家酌情使用。

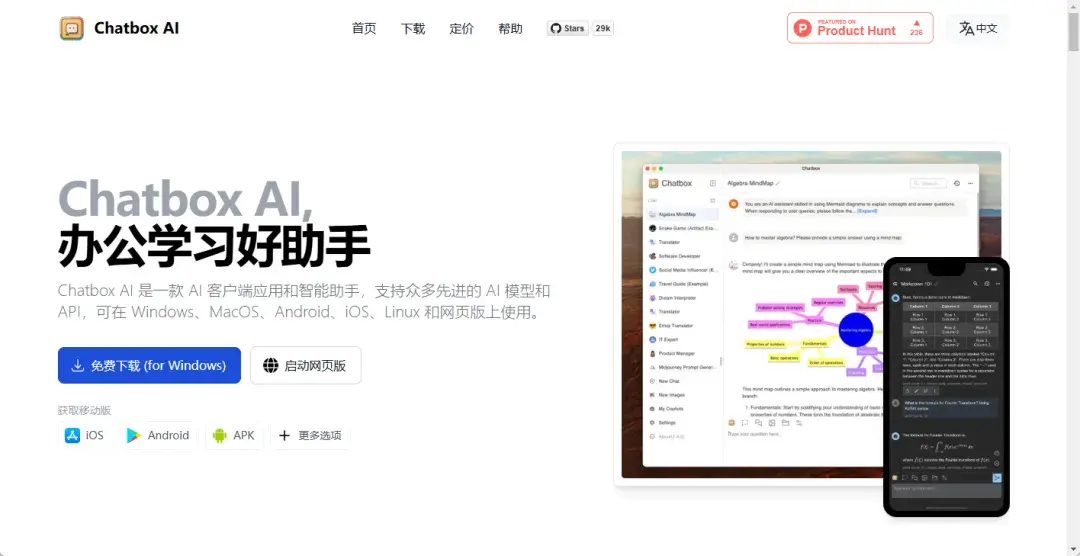

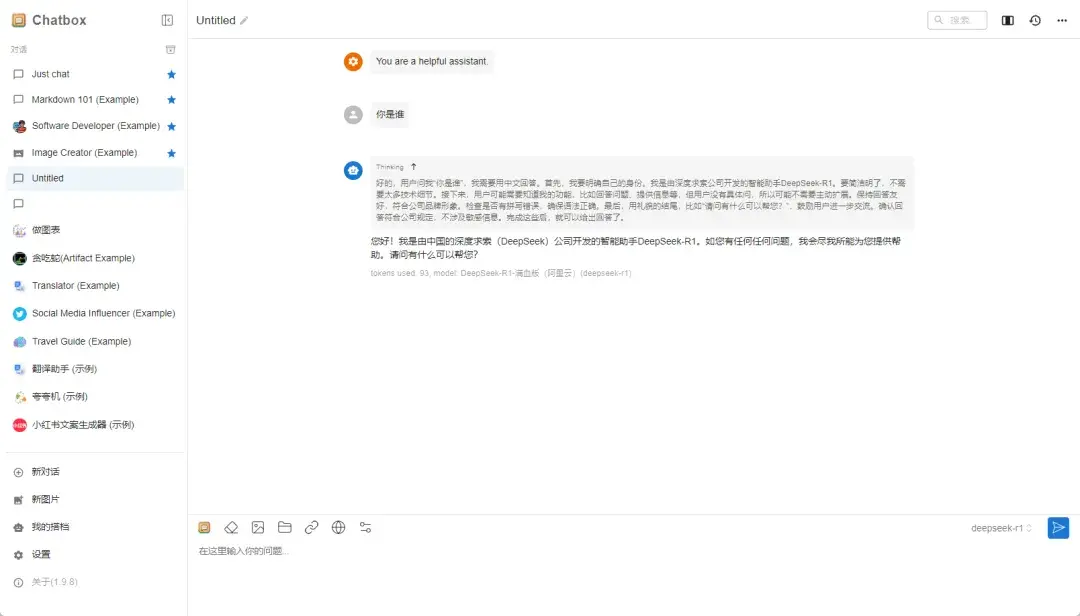

2、云服务API+ChatBox

除了直接使用官网和第三方服务之外,还可以通过API+ChatBox的方式来使用DeepSeek-R1-满血版。

随着DeepSeek的爆火,不少云服务商为了获取流量都提供了免费的DeepSeek-R1-满血版的API。

其中以硅基流动、腾讯云平台比较有代表性。

ChatBox是一个多功能的AI平台,主要以开源、跨平台的桌面客户端形式存在,支持多种操作系统(如Windows、macOS、Linux、Android和iOS)以及网页版。

其核心功能是为用户提供与大型语言模型(LLM)的交互体验,包括但不限于文本生成、图像生成、代码辅助、多语言支持和团队协作等功能。

通过ChatBox直接接入API就可以快速实现DeepSeek-R1的调用。

ChatBox网址:

https://chatboxai.app/zh

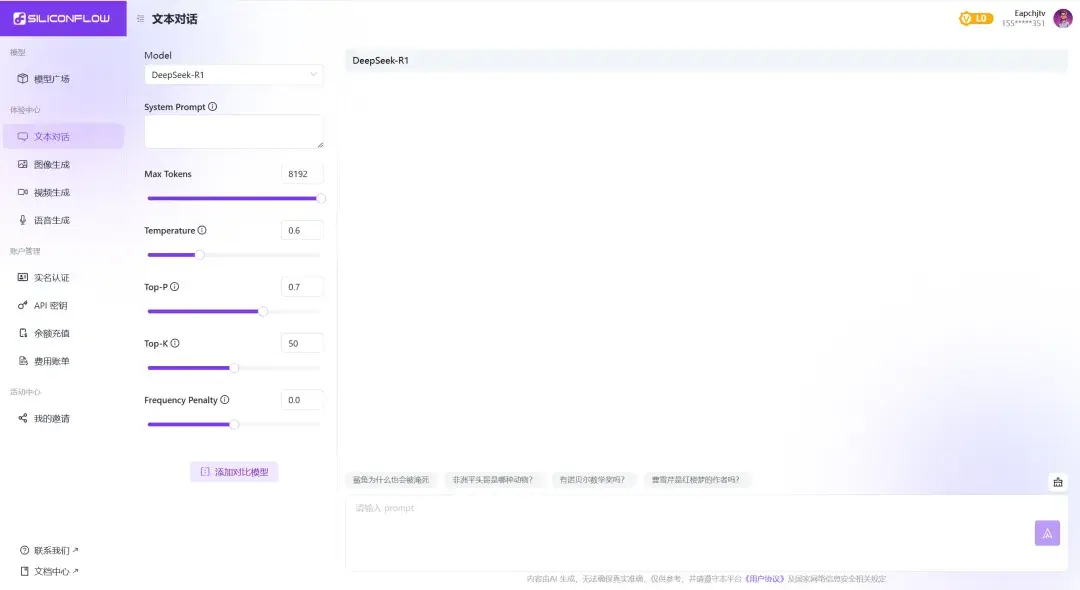

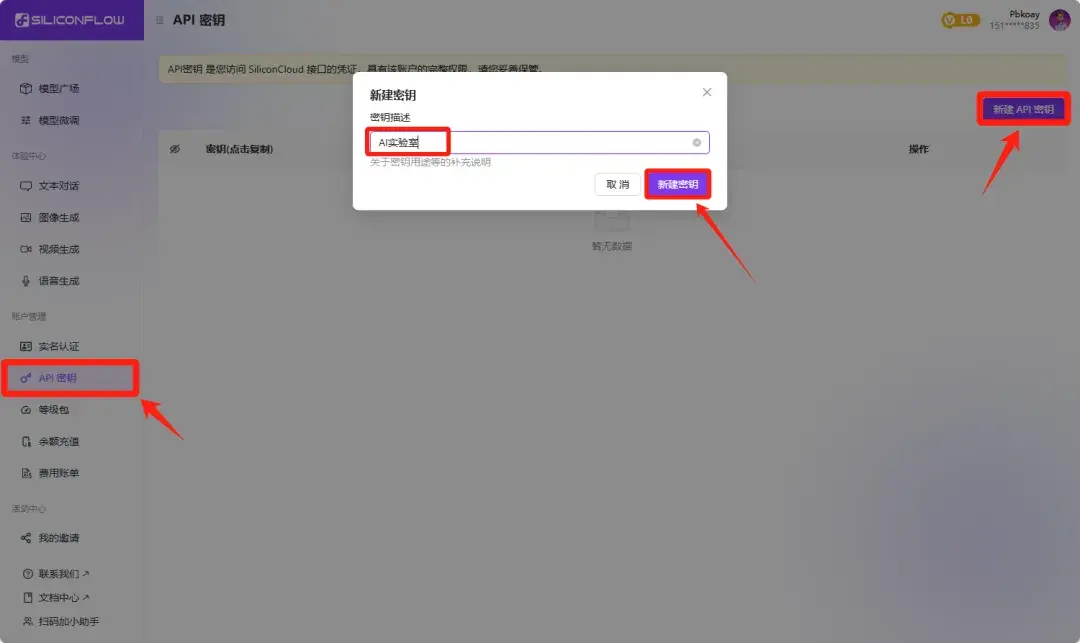

1)SiliconCloud(硅基流动)

SiliconCloud(硅基流动)除了可以在平台内直接使用DeepSeek-R1,最主要的功能是提供DeepSeek-R1的API通过其它平台进行调用。

网址:

https://cloud.siliconflow.cn/i/VV0oG3HA

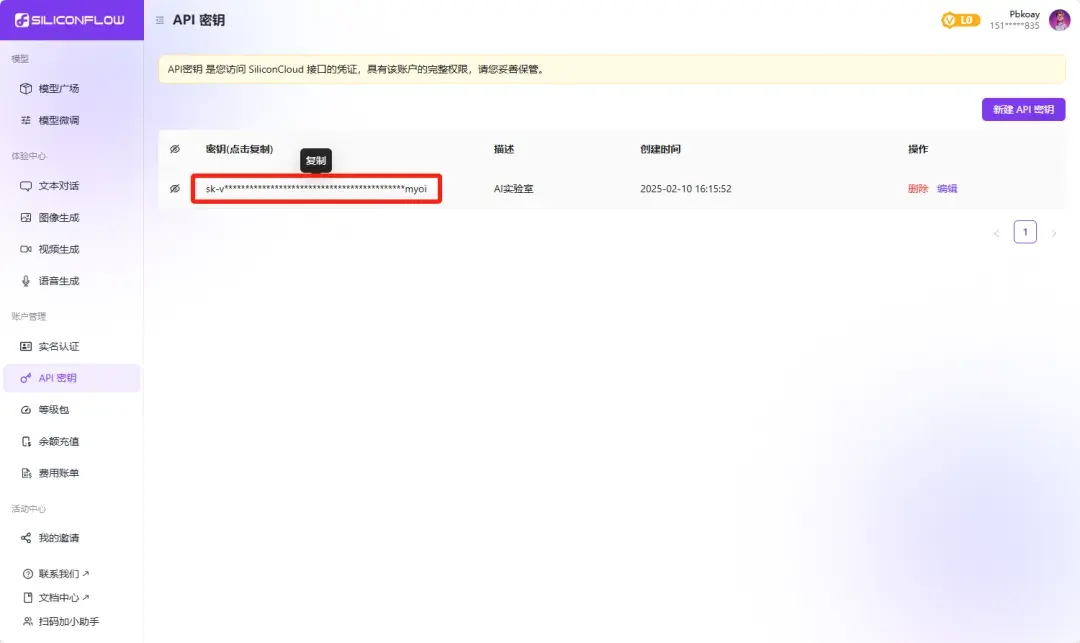

生成密钥:

登录后,在左侧菜单栏找到“API密钥”选项,点击“新建API密钥”,密钥描述可以随便填写:

密钥生成好之后鼠标移动到密钥上点击复制密钥(格式以sf-开头)

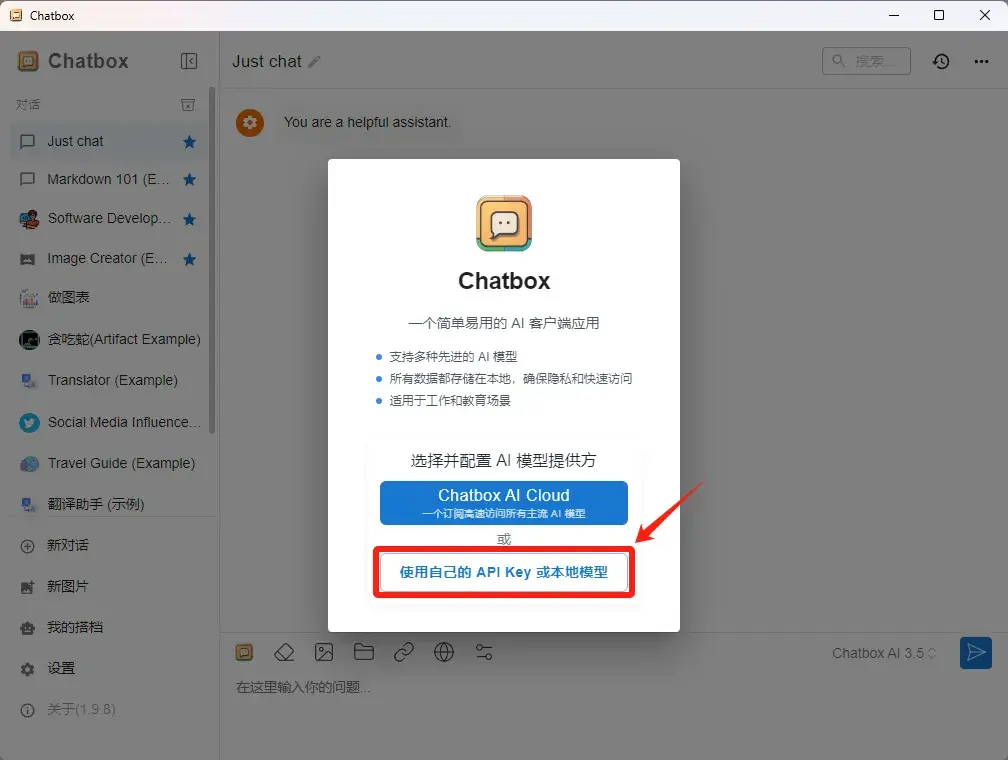

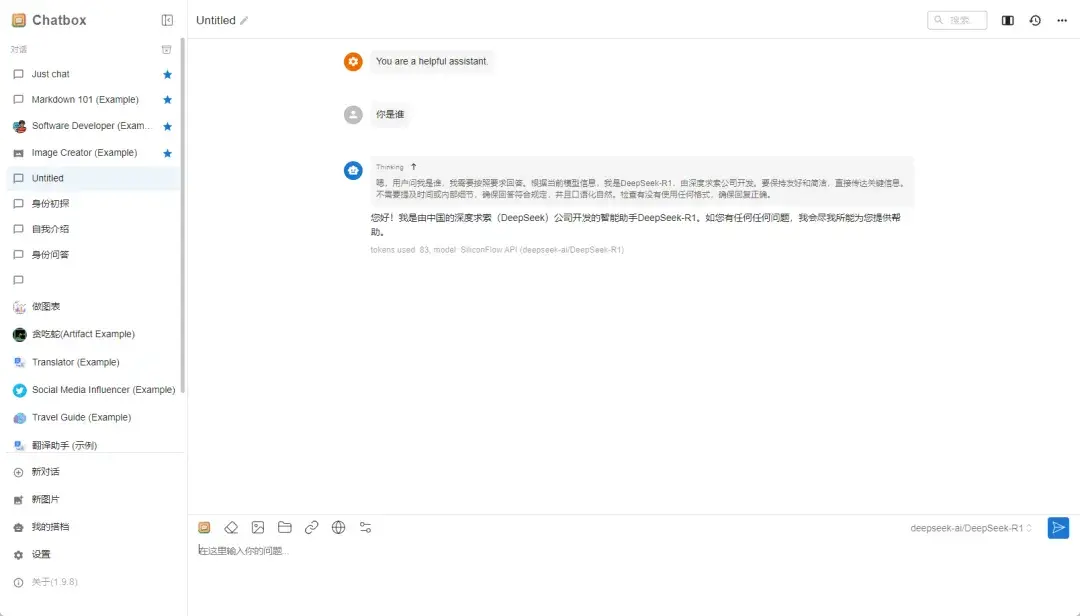

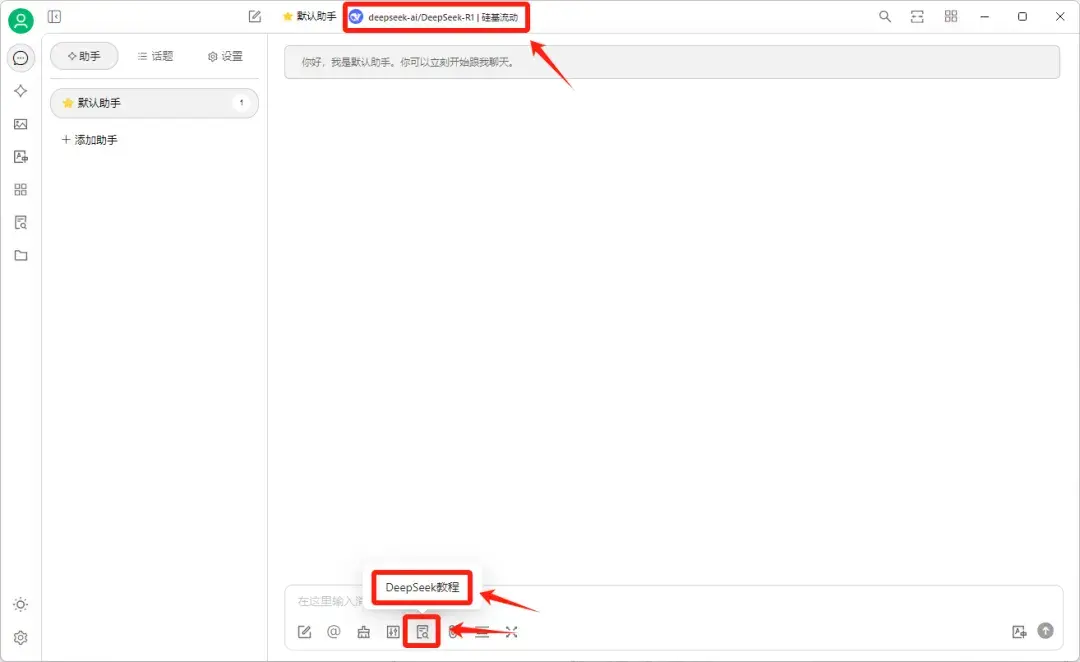

下载安装ChatBox客户端(或者手机APP),安装时避免选择系统盘(如Windows的C盘)

下载好之后选择使用自己的API Key或本地模型:

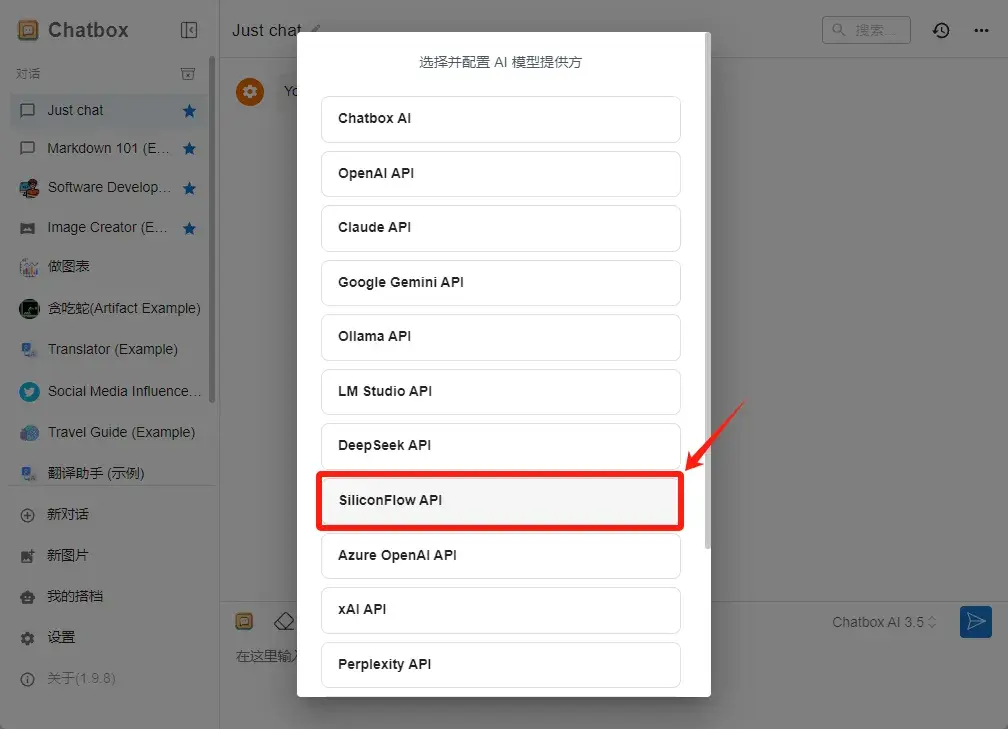

在AI模型提供方列表里找到并选择SilicionFlow API:

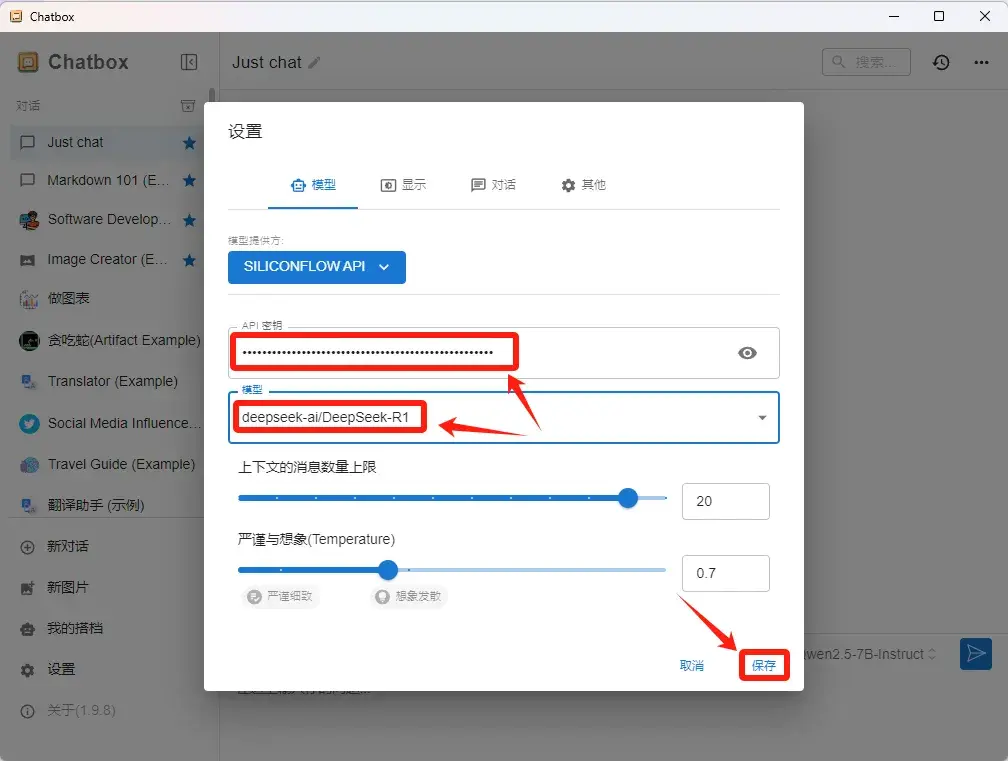

然后把刚刚复制好的密钥填写到API密钥栏

模型选择deepseek-ai/DeepSeek-R1

点击保存:

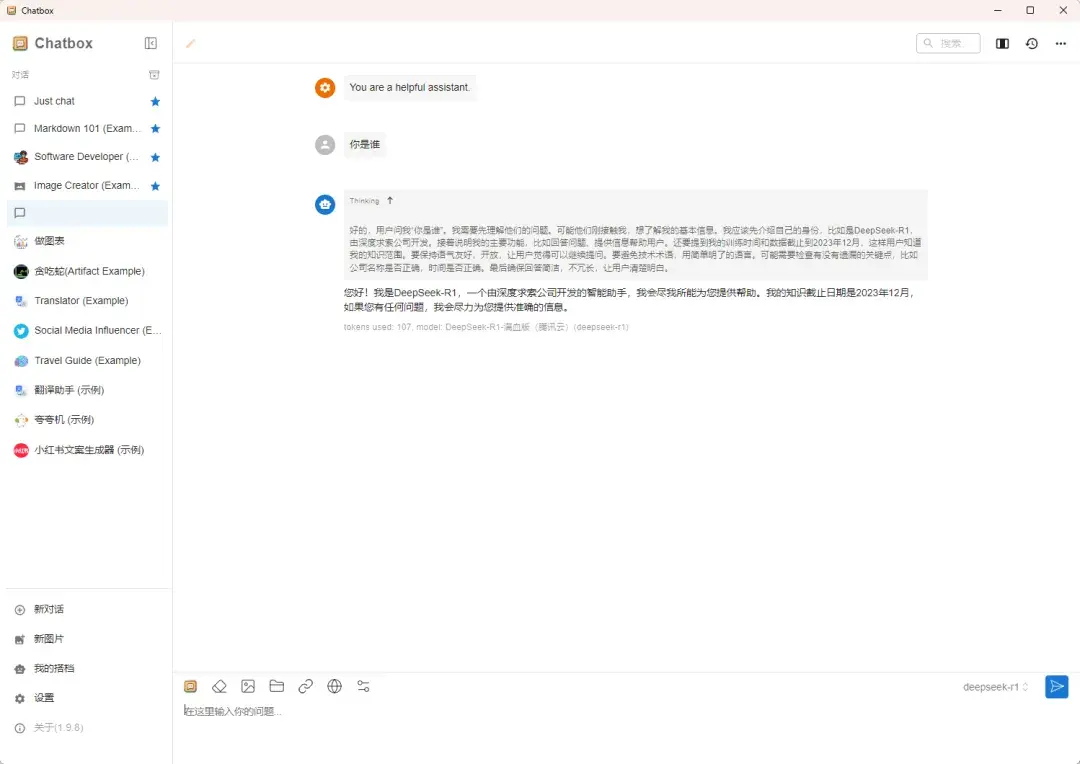

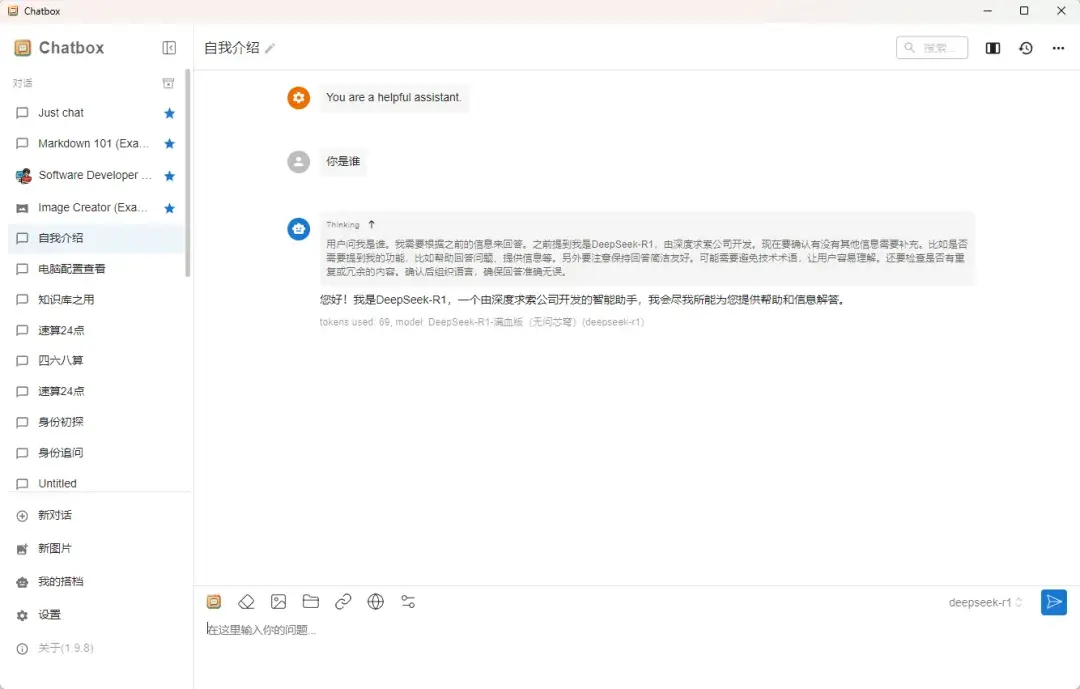

然后就可以在ChatBox里调用DeepSeek-R1了:

SiliconCloud(硅基流动)新用户赠送的2000万tokens可以使用差不多1w次左右,对于普通用户来说足够用上几个月了。

不过上文也提到,随着硅基流动涌入的新用户越来越多,和DeepSeek官网一样,会因为并发量过大导致回答卡顿或者服务器繁忙,尤其是下午时段比较频繁出现这个问题。

如果遇到这种情况可以选择使用其他云服务平台的API接入ChatBox进行使用。

2)腾讯云

除了硅基流动之外,还有许多云服务平台部署了满血版(671B参数)的DeepSeek-R1大模型并免费对用户开放。

以腾讯云为例,即日起到2月26日之前,所有用户都可以免费无限次调用DeepSeek-V3和DeepSeek-R1模型。

网址:

https://cloud.tencent.com/login?s_url=https%3A%2F%2Fconsole.cloud.tencent.com%2Flkeap

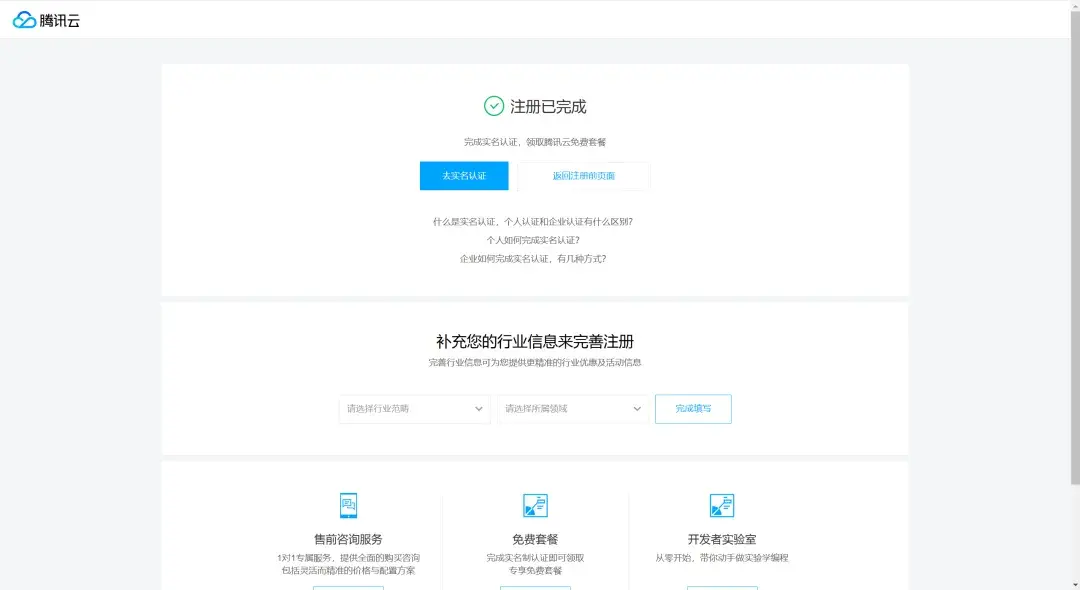

(首次使用腾讯云的话需要先注册并且实名认证一下)

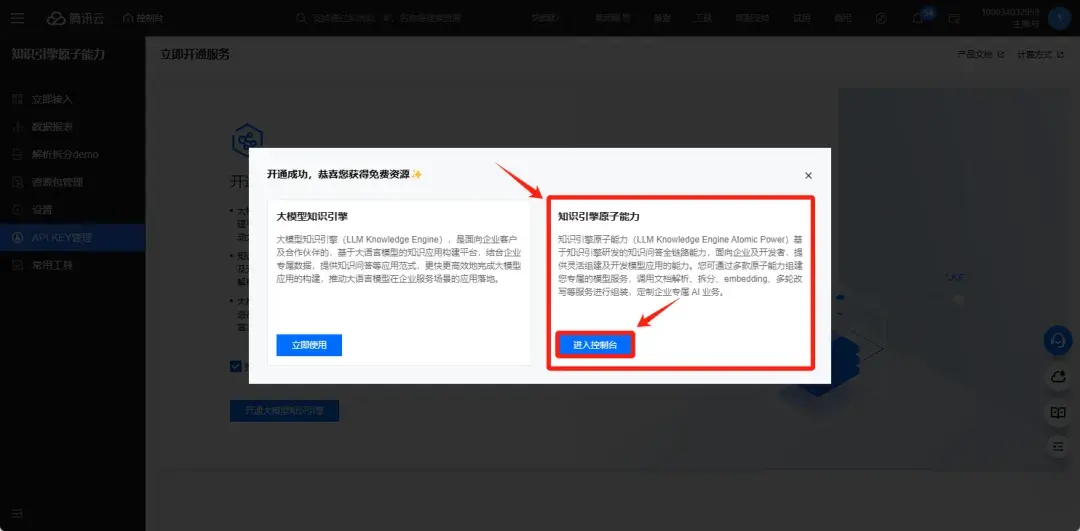

实名认证完成之后重新打开链接就可以进入知识引擎原子能力控制台界面:

勾选同意条款并点击开通大模型知识引擎

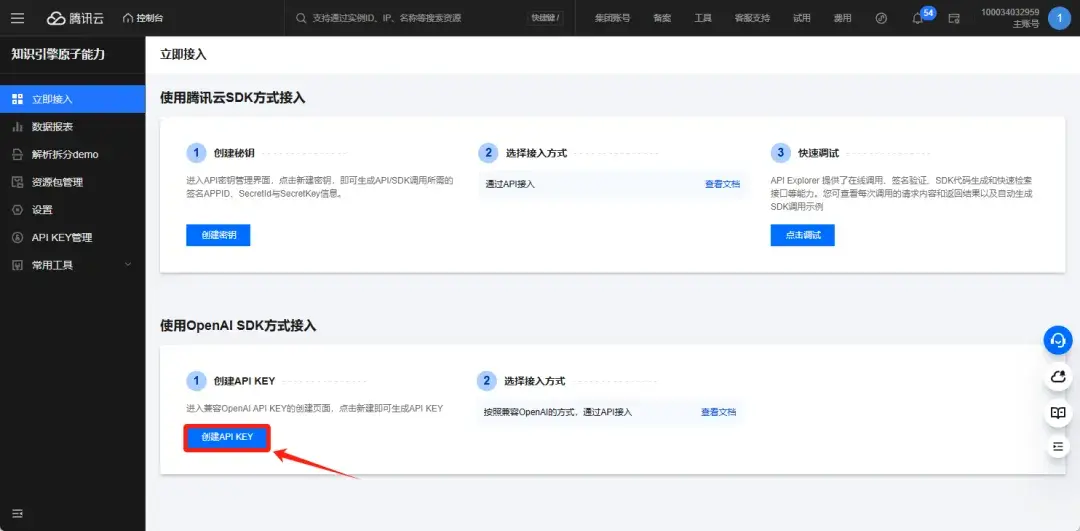

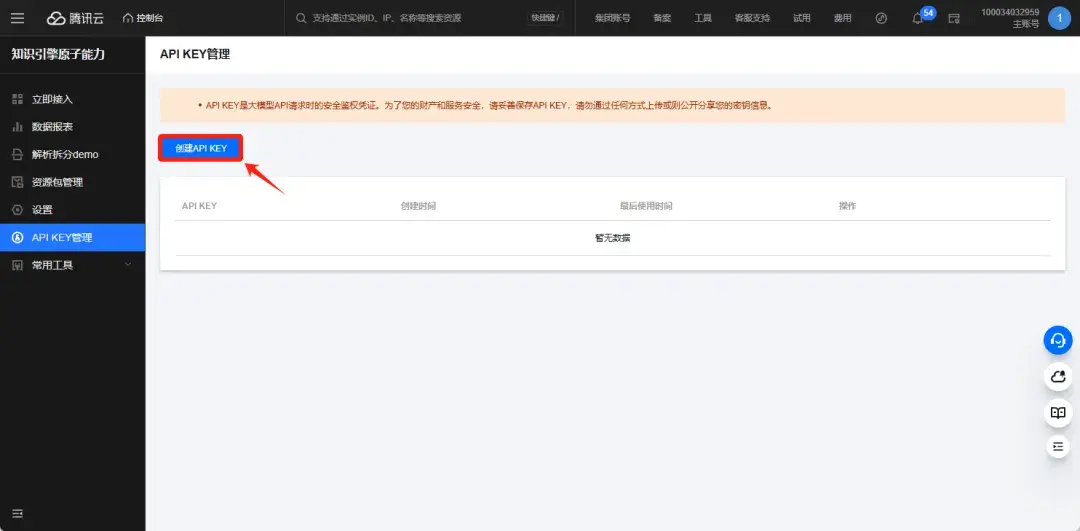

选择创建API KEY:

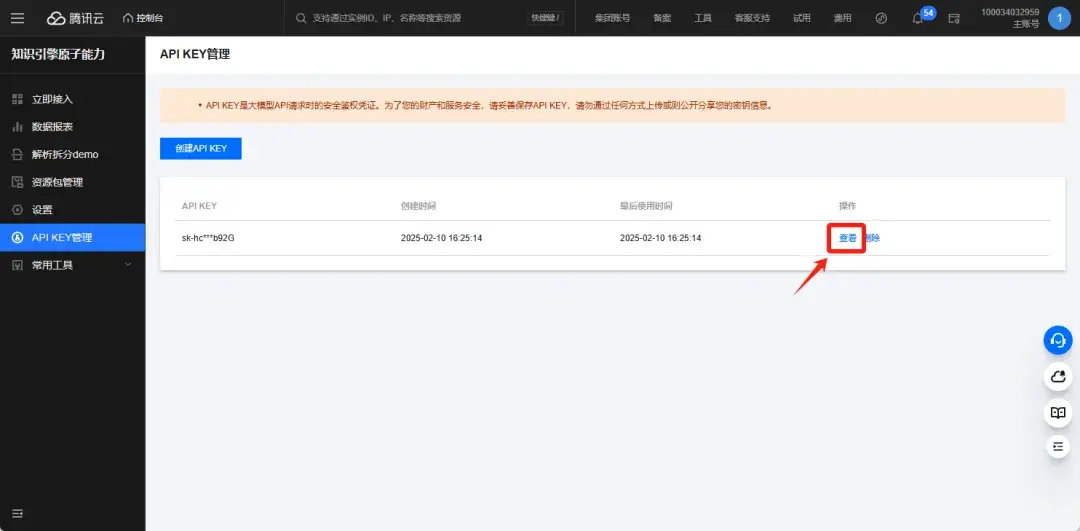

创建好之后点击查看就可以看到完整的Key:

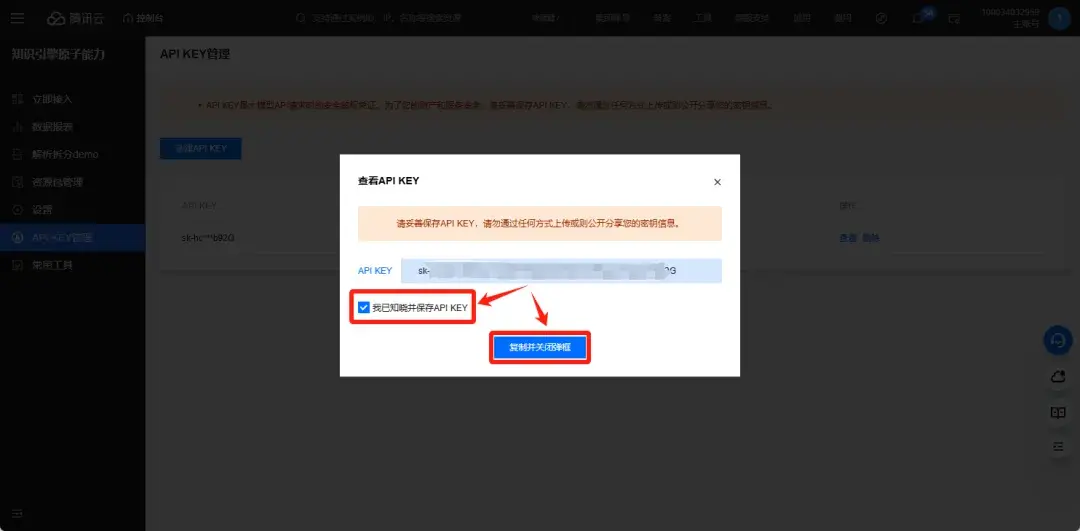

然后勾选我已知晓 — 点击复制并关闭弹框,这样API KEY就复制下来了:

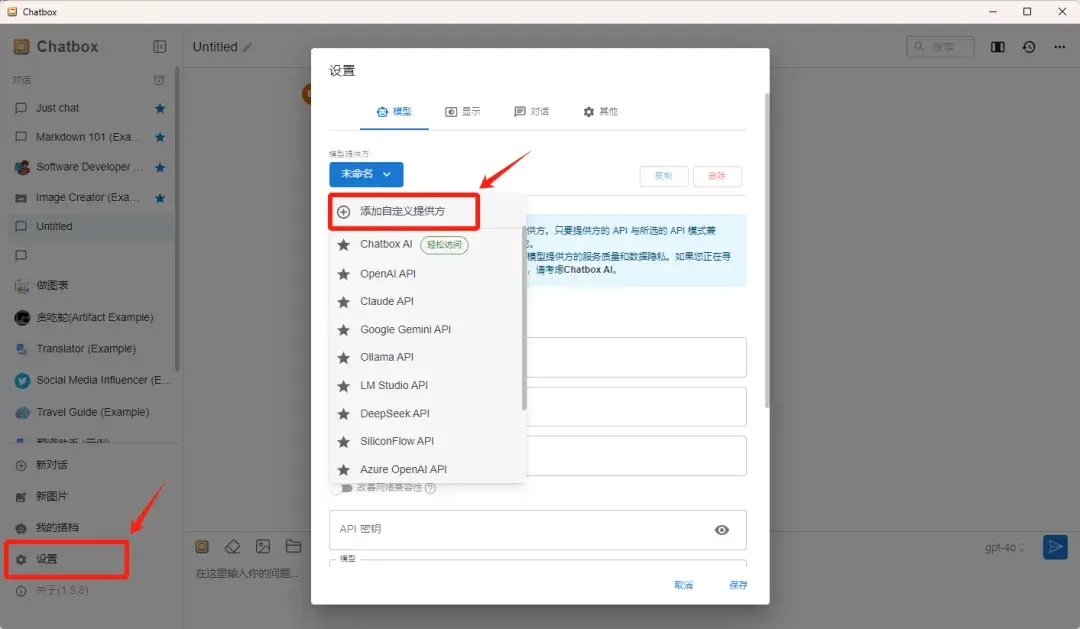

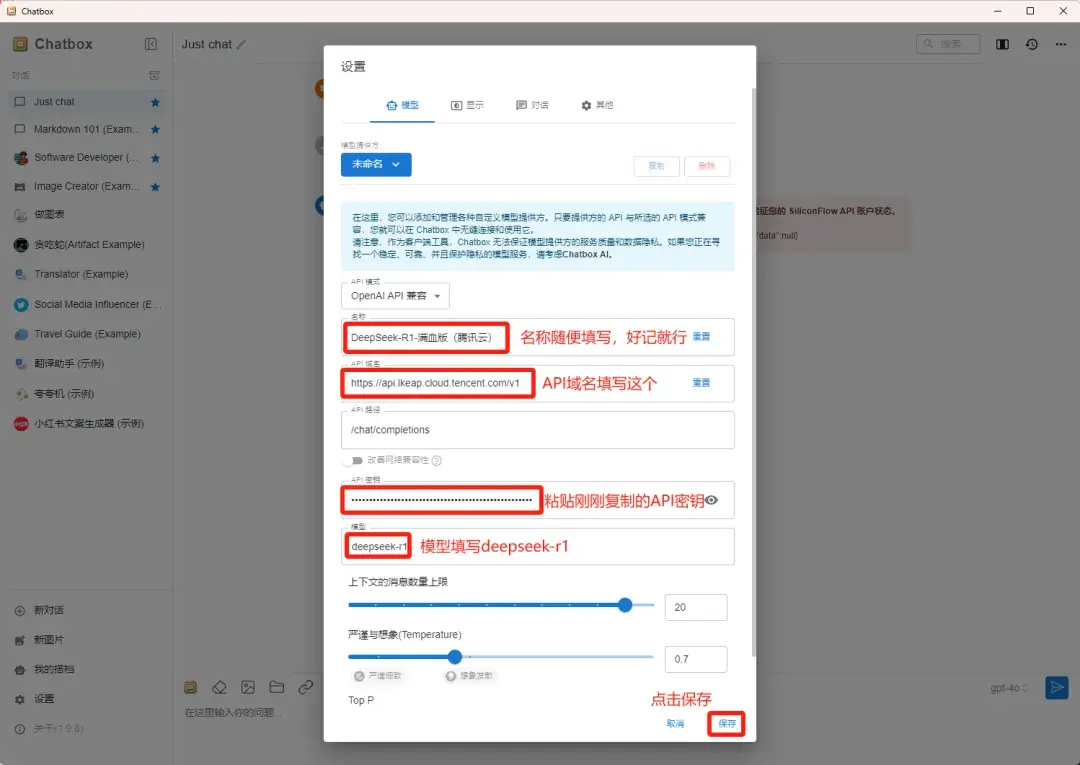

然后打开ChatBox,点击左下方设置,模型提供商选择“添加自定义提供方”:

然后按照下面这张图标注的填写API信息:

- 名称:按照自己的想法随便填写就可以

- API域名:https://api.lkeap.cloud.tencent.com/v1

- API路径:chat/completions(默认配置)

- API密钥:刚刚在腾讯云获取的API KEY

- 模型:填写deepseek-r1

全部参数都配置好之后点击保存,就可以在ChatBox里调用腾讯云的DeepSeek-R1-满血版了。

亲测速度比硅基流动要快得多!

3)阿里云百炼

除了腾讯云,阿里云也在自己的阿里云百炼平台上线了满血版的DeepSeek-R1模型。

每个新用户可以免费获得每个模型100万tokens。

网址:

https://www.aliyun.com/product/bailian

调用方法和腾讯云基本一致,先在平台申请API KEY,然后接入ChatBox。

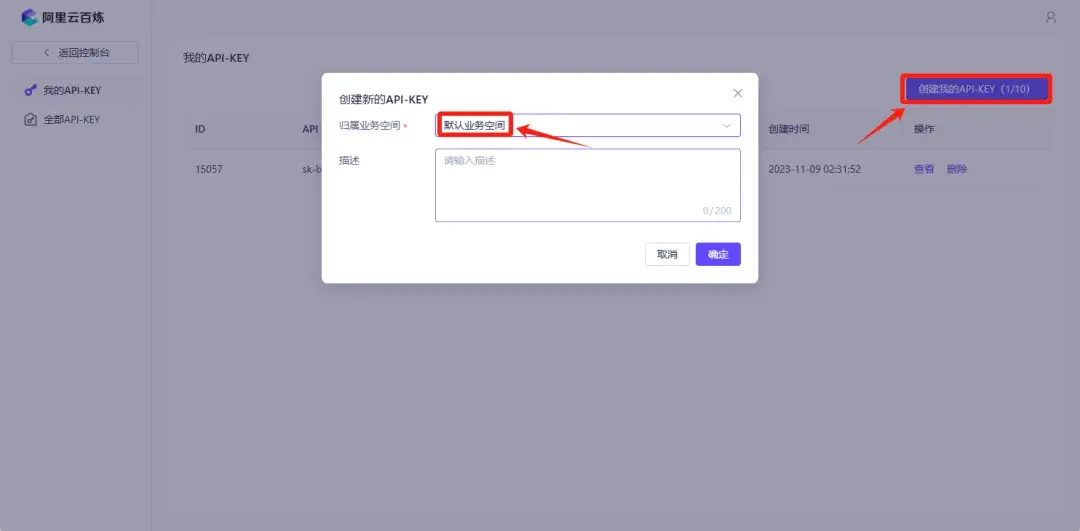

进入阿里云百炼页面(首次注册使用可能需要实名认证),点击右上角个人中心,找到API-KEY选项并点击:

然后选择“创建我的API-KEY”,归属业务空间直接选择默认业务空间就可以,点击确定,API KEY就创建好了:

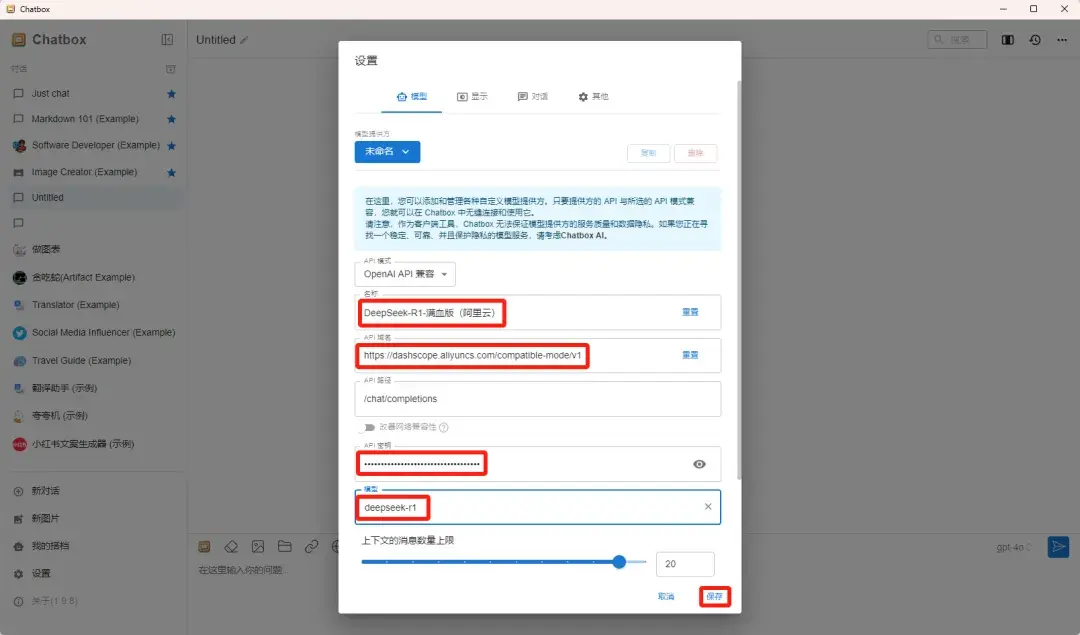

同样打开ChatBox的设置功能,和腾讯云一样,选择“添加自定义提供方”。

然后按照刚才的方法配置参数:

- 名称:按照自己的想法随便填写就可以

- API域名:https://dashscope.aliyuncs.com/compatible-mode/v1

- API路径:chat/completions(默认配置)

- API密钥:刚刚在阿里云百炼获取的API KEY

- 模型:填写deepseek-r1

和腾讯云的区别就是换了一下API域名和API KEY,其余参数配置基本都一样。

然后点击保存,就可以在ChatBox里调用阿里云百炼平台的DeepSeek-R1-满血版了。

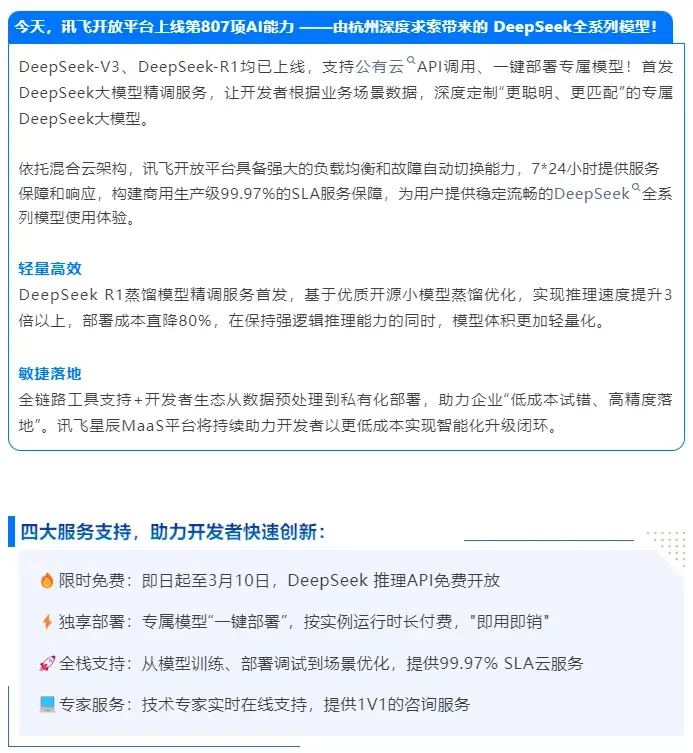

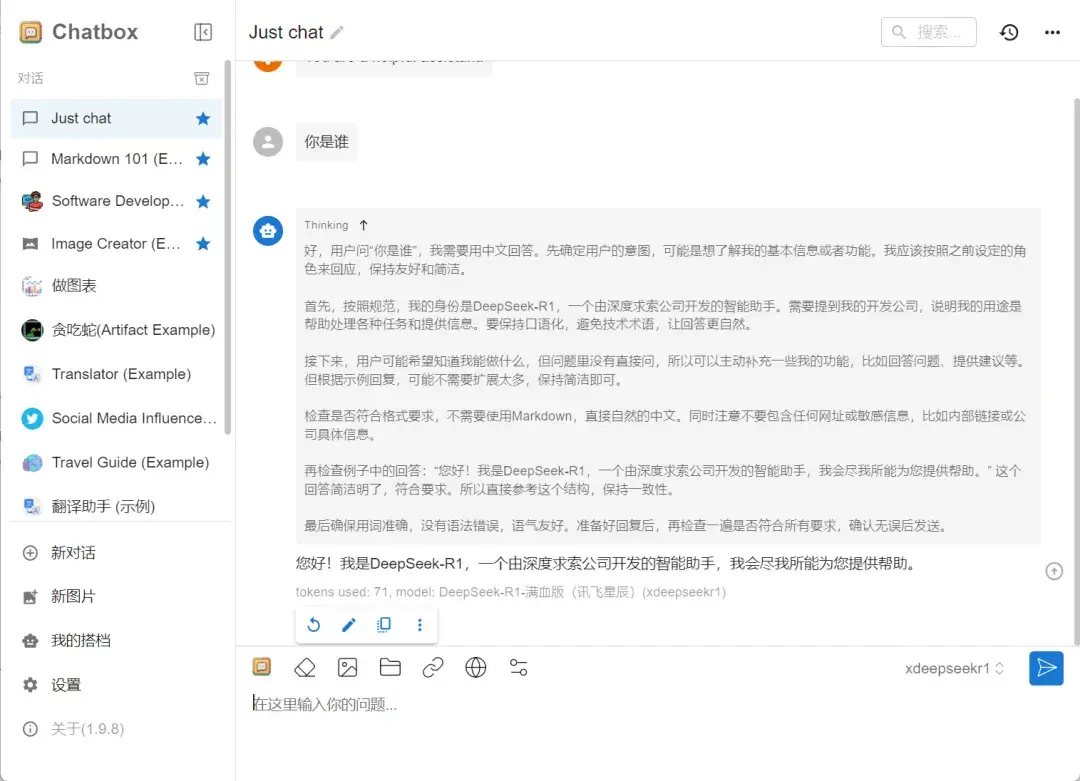

4)讯飞星辰(强烈推荐)

除了上面分享的腾讯云和阿里云之外,讯飞开放平台也上线了DeepSeek全系列模型,可以直接通过讯飞开放平台调用DeepSeek-V3和DeepSeek-R1模型。

并且即日起到2025年3月10日,DeepSeek推理API免费开放,无限制使用,可以说是这几家云服务平台里最大方的了,速度亲测也相当快!

讯飞开发平台网址:

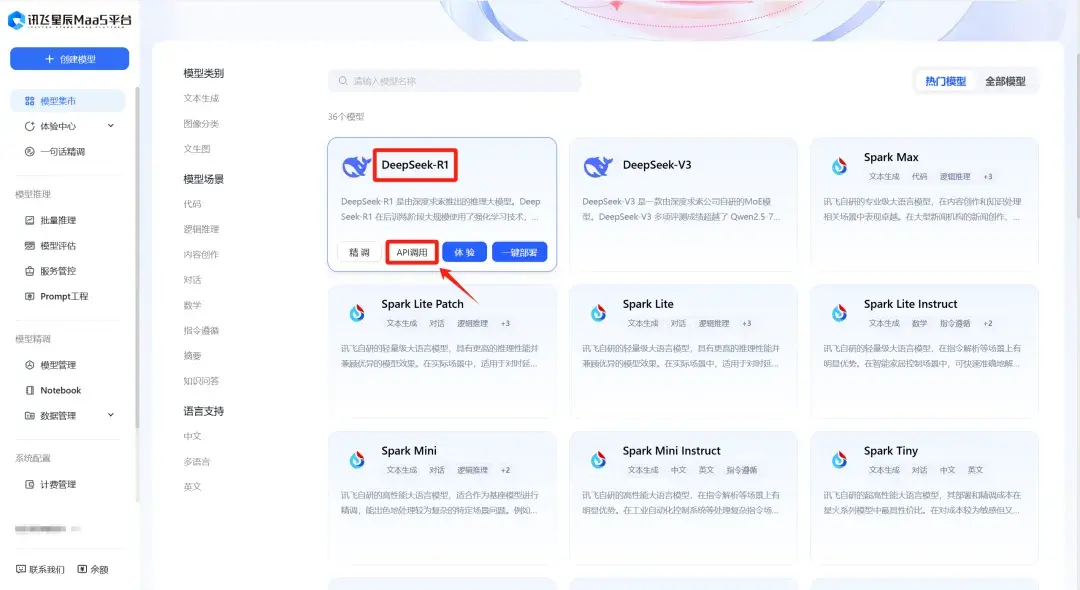

https://training.xfyun.cn/modelSquare

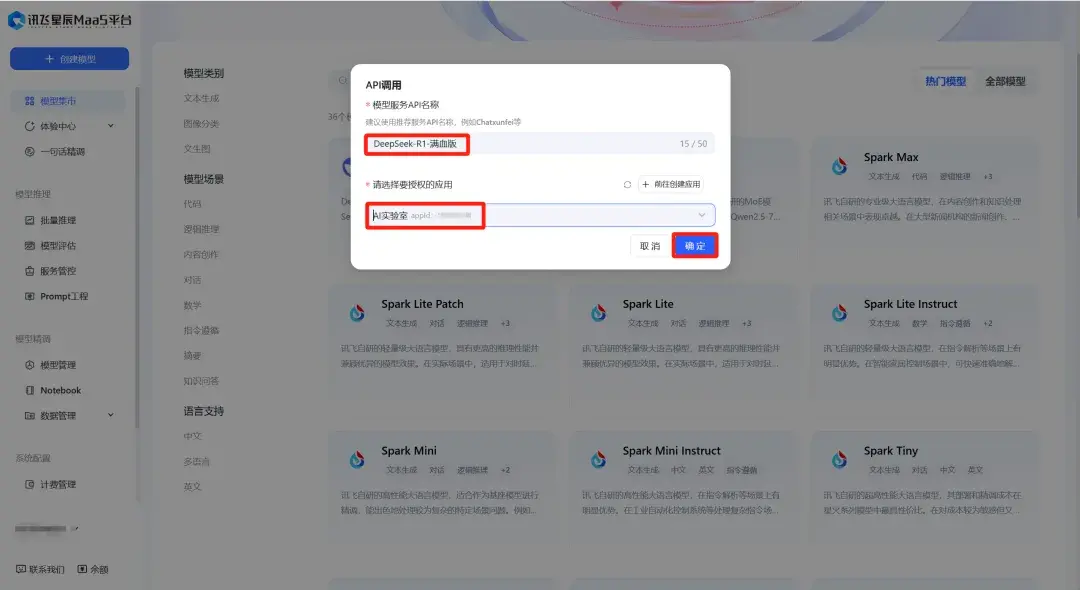

注册登录讯飞开放平台后,排在第一位的看到DeepSeek-R1模型,鼠标移动上去就可以看到API调用的入口:

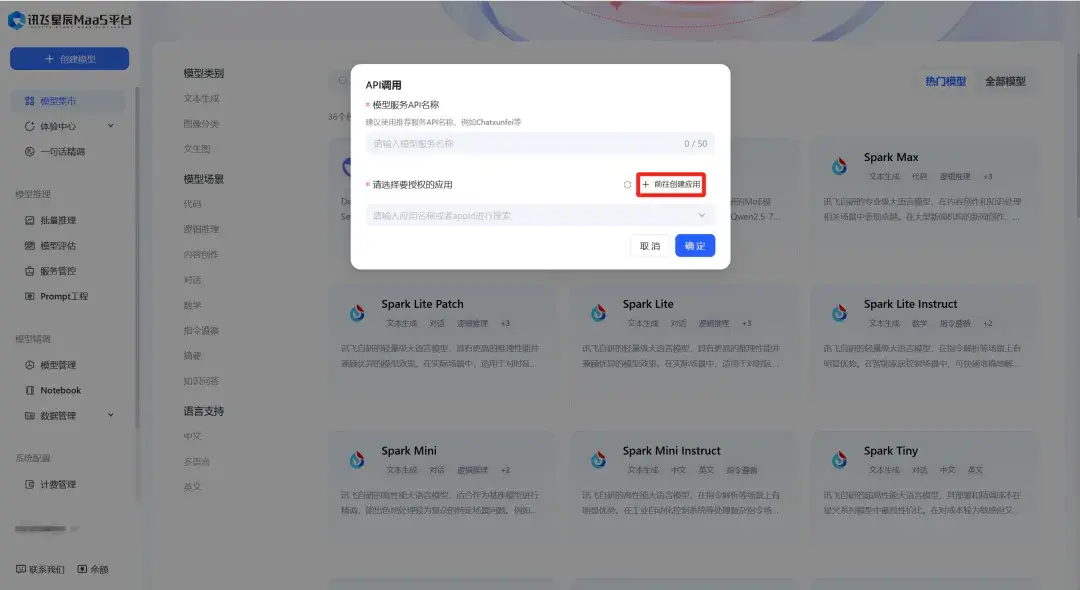

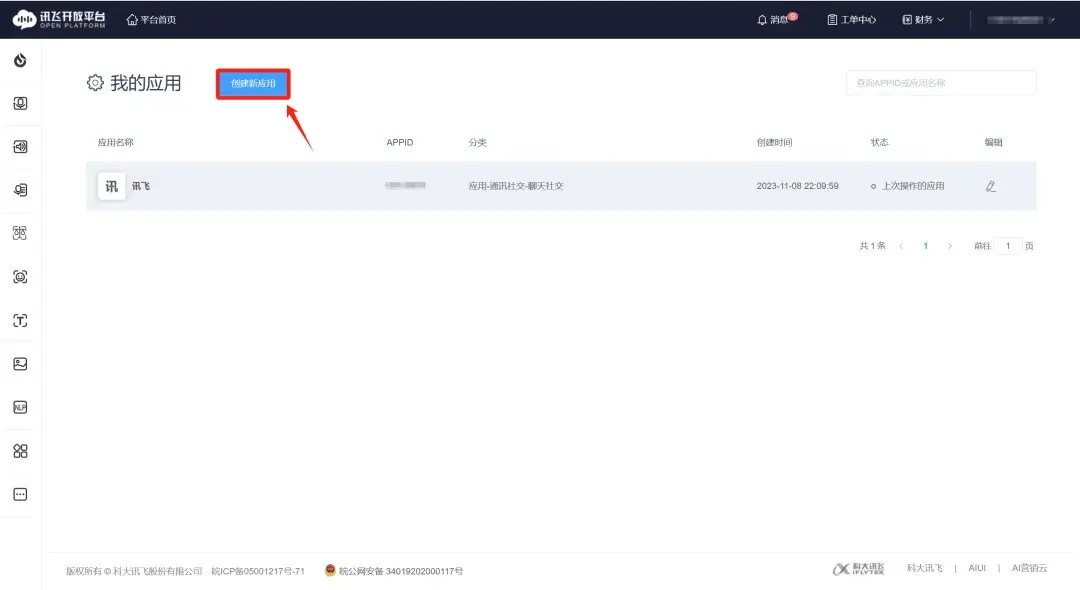

点击API调用,如果是第一次使用,先点击“前往创建应用”

选择“创建新应用”:

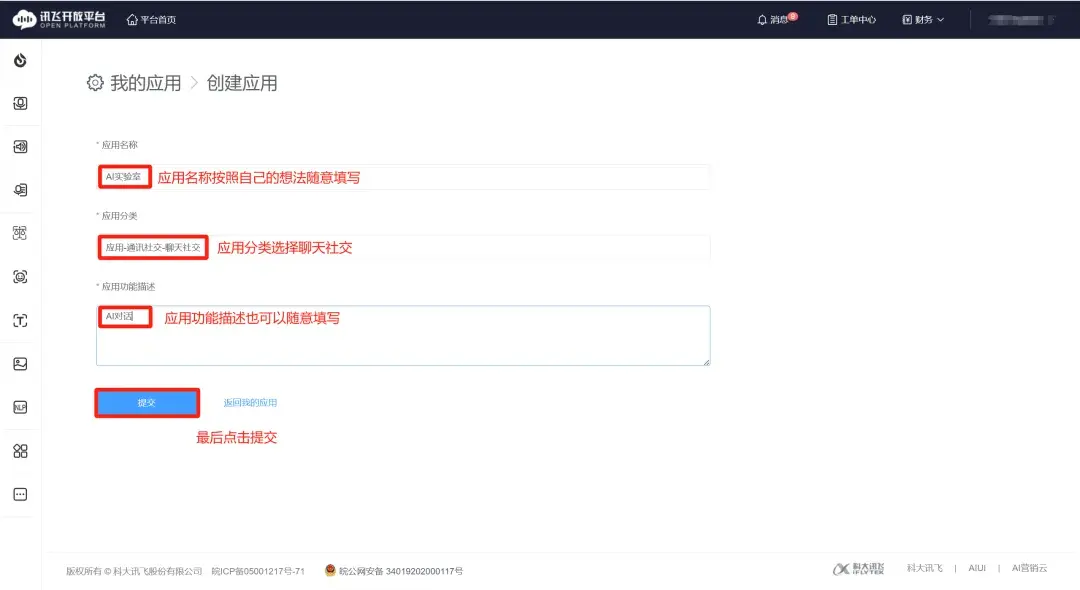

然后回到刚才的API调用界面,名称按照自己的习惯填写即可,要授权的应用选择刚刚创建的应用,然后点击确定:

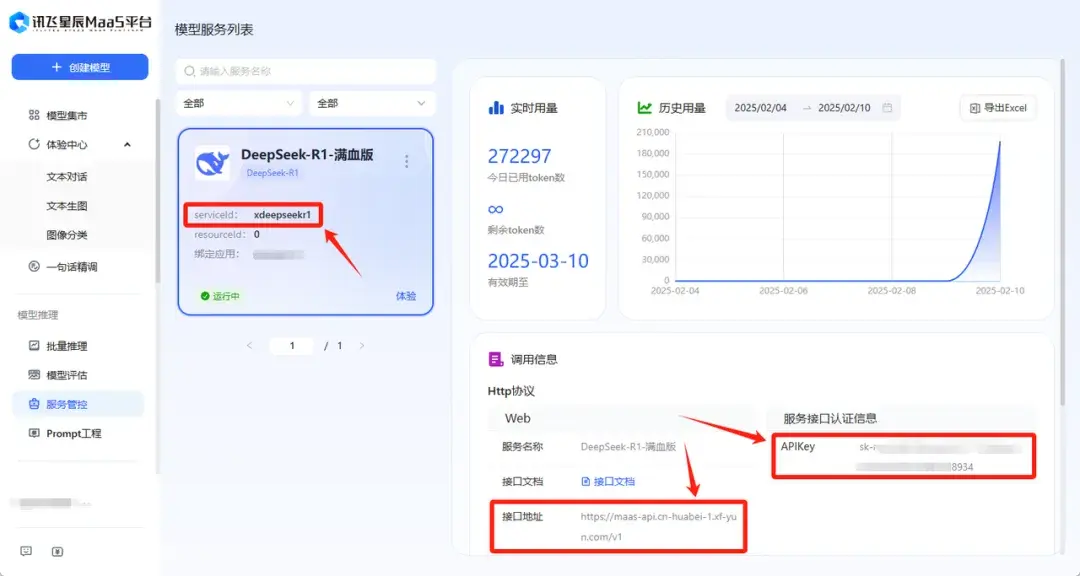

然后就可以看到创建好的模型服务,这个界面有三个参数需要记住:

serviceID、APIKey和接口地址

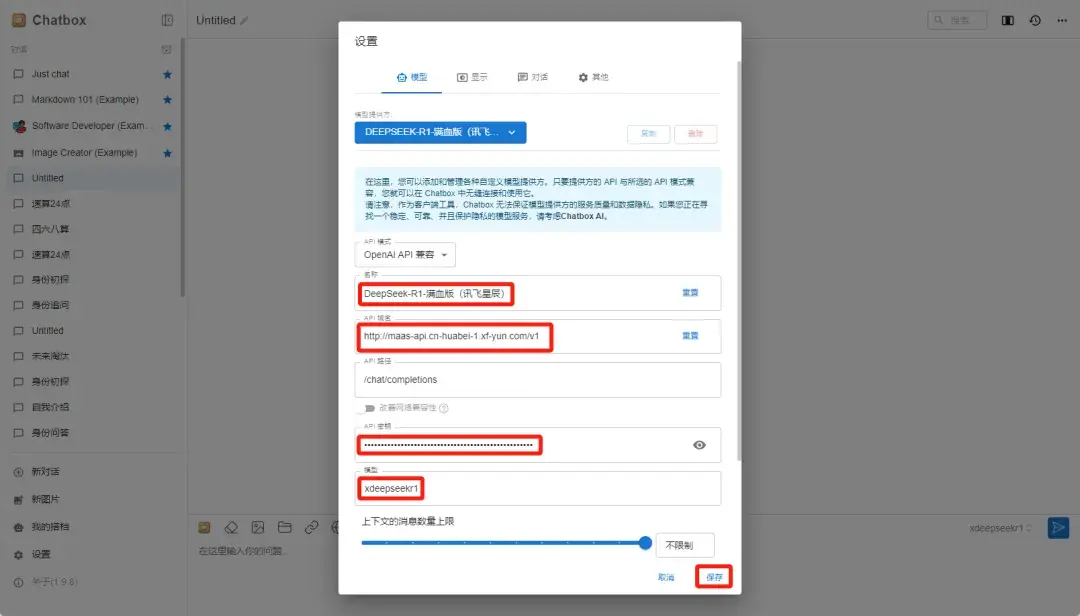

然后打开ChatBox的设置界面,同样选择选择“添加自定义提供方”,并按照以下参数去配置:

- 名称:按照自己的想法随便填写就可以

- API域名:https://maas-api.cn-huabei-1.xf-yun.com/v1(就是接口地址)

- API路径:chat/completions(默认配置)

- API密钥:刚刚在讯飞开发平台获取的API KEY

- 模型:填写xdeepseekr1(就是serviceId)

然后点击保存,就可以在ChatBox里调用讯飞开放平台的DeepSeek-R1-满血版了。

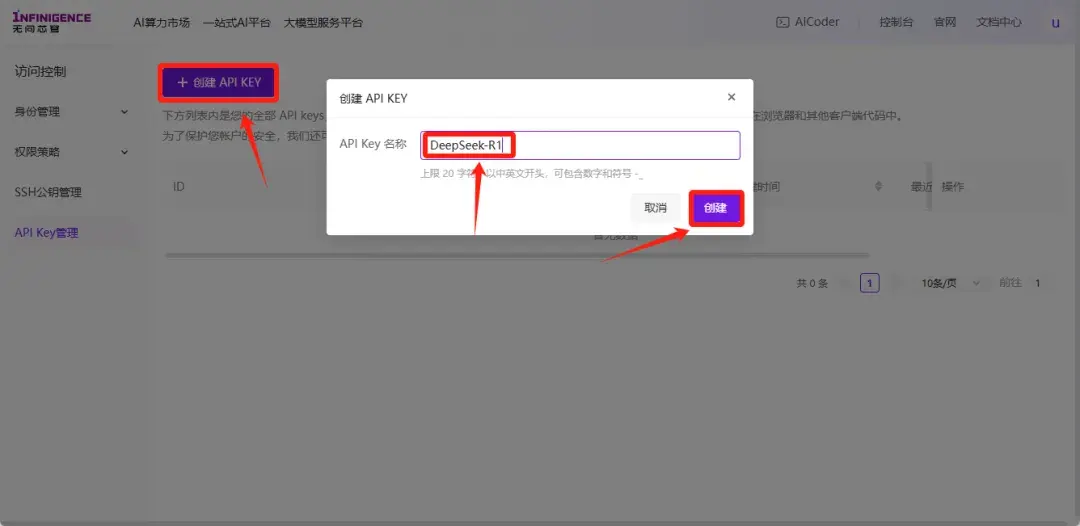

5)无问芯穹

除了以上云服务厂商,2月10清华团队的无问芯穹大模型服务平台也对外官宣,上线满血版DeepSeek-R1、V3 API服务,并且无需邀请即可免费用Token!

网址:

https://cloud.infini-ai.com/login

手机号注册登录后进入主页,点击“开启体验之旅”:

就可以看到大模型服务平台界面,整体界面和硅基流动大差不差,点击“API KEY管理:

在API管理界面创建新的API KEY:

创建好之后,把Key复制下来:

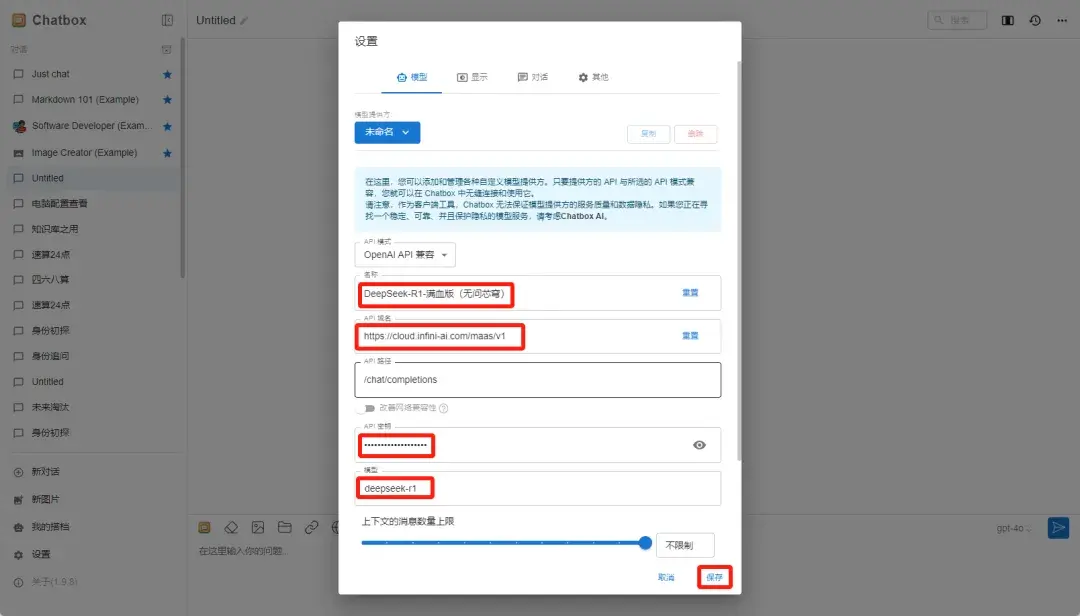

然后按照相同的方式在ChatBox进行配置,参数配置如下:

- 名称:按照自己的想法随便填写就可以

- API域名:https://cloud.infini-ai.com/maas/v1

- API路径:chat/completions(默认配置)

- API密钥:刚刚在获取的API KEY

- 模型:填写deepseek-r1

配置好之后就可以在ChatBox里进行调用了:

除了以上平台之外,还有火山引擎也在自家平台部署了满血版R1,每个用户有50万tokens的免费额度,使用方法和上面的步骤基本一致。

网址:

https://www.volcengine.com/

不过50万的tokens和上面这几个平台相比确实少了点,所以这里就不详细展开了。

(注:如果想要付费使用R1的话,推荐火山引擎,速度快,质量高,免费使用的话上面这几个平台就足够用了)

三、本地部署

1、硬件配置

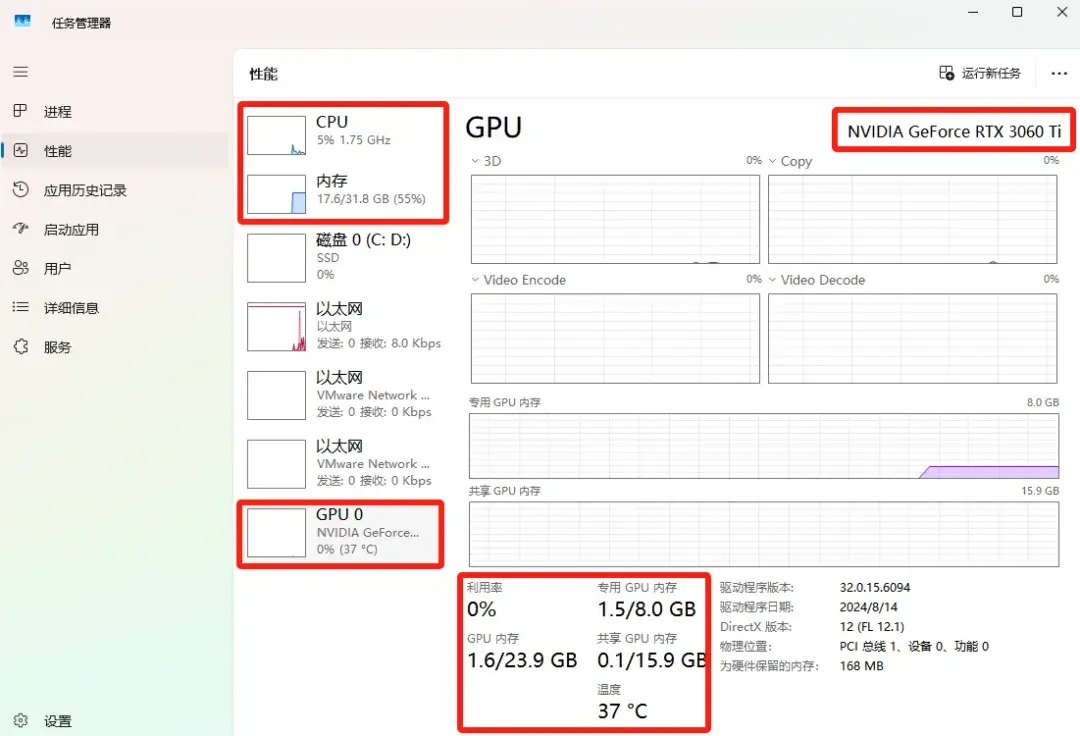

首先说明,个人电脑本地部署DeepSeek是跑不动满血版的R1的,只能部署1.5B到32B的版本。

大部分部署的都是1.5B/7B/8B的小参数版本,高端显卡(24GB显存)可以部署14B/32B的版本。

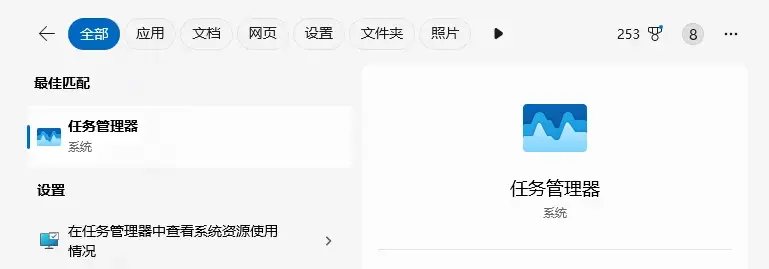

如果不清楚自己电脑配置的话,打开电脑的任务管理器:

点击性能就可以查看自己的电脑配置:

以下是从网上整理的一些关于本地部署DeepSeek-R1的硬件配置需求清单,可以根据自己的电脑配置评估一下:

1)小型模型

DeepSeek-R1-1.5B

- 硬件配置

- CPU:最低 4 核

- 内存:8GB+

- 硬盘:256GB+(模型文件约 1.5-2GB)

- 显卡:非必需(纯 CPU 推理)

- 适用场景

- 本地测试,个人电脑配合 Ollama 轻松运行

- 预计费用:2,000~5,000

2)中型模型

DeepSeek-R1-7B

- 硬件配置

- CPU:8 核+

- 内存:16GB+

- 硬盘:256GB+(模型文件约 4-5GB)

- 显卡:推荐 8GB+ 显存(如 RTX 3070/4060)

- 适用场景

- 本地开发与测试

- 中等复杂度任务(文本摘要、翻译、轻量级对话系统)

- 预计费用:5,000~10,000

DeepSeek-R1-8B

- 硬件配置

- 同 DeepSeek-R1-7B

- 适用场景

- 高精度轻量级任务(代码生成、逻辑推理)

- 预计费用:5,000~10,000

3)大型模型

DeepSeek-R1-14B

- 硬件配置

- CPU:12 核+

- 内存:32GB+

- 硬盘:256GB+

- 显卡:16GB+ 显存(如 RTX 4090 或 A5000)

- 适用场景

- 企业级复杂任务(长文本理解与生成)

- 预计费用:20,000~30,000

DeepSeek-R1-32B

- 硬件配置

- CPU:16 核+

- 内存:64GB+

- 硬盘:256GB+

- 显卡:24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

- 适用场景

- 高精度专业领域任务(多模态预处理)

- 预计费用:40,000~100,000

4)超大型模型

DeepSeek-R1-70B

- 硬件配置

- CPU:32 核+

- 内存:128GB+

- 硬盘:256GB+

- 显卡:多卡并行(如 2x A100 80GB 或 4x RTX 4090)

- 适用场景

- 科研机构/大型企业高复杂度生成任务

- 预计费用:400,000+

DeepSeek-R1-671B

- 硬件配置

- CPU:64 核+

- 内存:512GB+

- 硬盘:512GB+

- 显卡:多节点分布式训练(如 8x A100/H100)

- 适用场景

- 超大规模 AI 研究或通用人工智能(AGI)探索

从性能上来说,DeepSeek-R1-满血版(671B)和其它参数版本的R1其实都算不上是同一种模型,因为性能差距太大。

即使是671B的V3模型和满血版的R1都有着不小的差距,更不用说只有几B和几十B的小模型了。

所以如果你想使用的是DeepSeek-R1-满血版,那本地部署对你来说基本没有什么意义,直接使用上面那几种方法通过云端使用就可以了。

如果你对本地部署感兴趣或者有本地部署的需求,那可以按照下面的方法进行本地部署。

2、本地部署方法

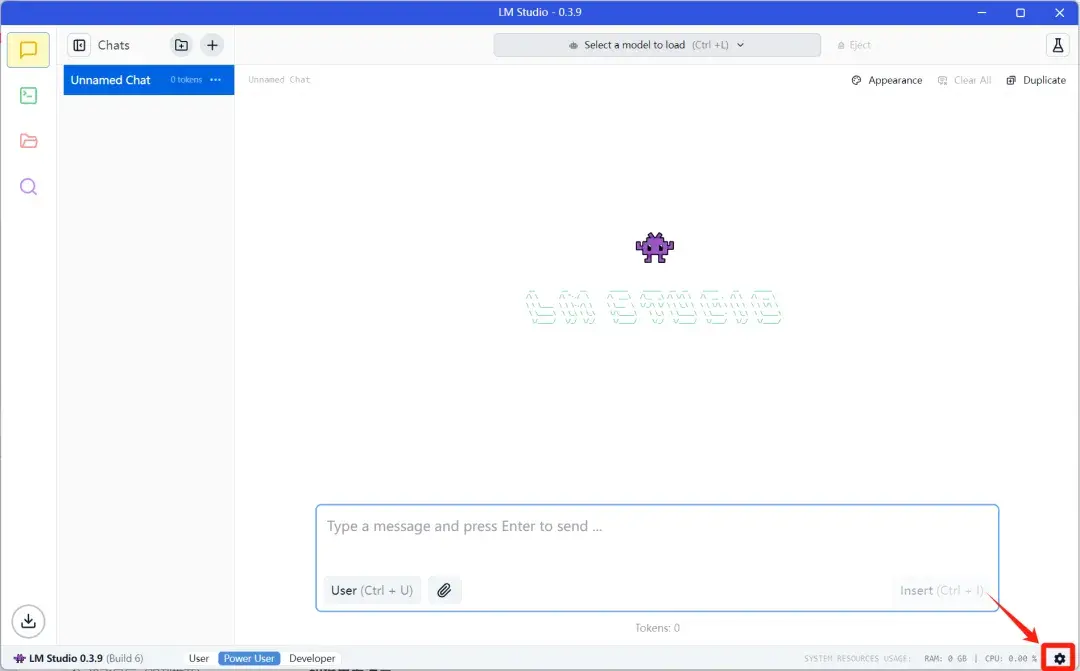

1)下载LM Studio客户端

网上的本地部署教程大多都是通过Ollama来本地部署DeepSeek-R1模型,这种方式也是目前比较主流的方式。

不过因为部署过程中会涉及到一些命令行操作和环境设置,所以对于大多数没什么计算机基础的朋友来说,部署流程会比较繁琐.

并且过程中一旦遇到问题就很难解决。

所以这里比较推荐大家直接使用LM Studio+本地大模型来进行部署,可以免去环境配置的麻烦,部署起来会方便很多。

LM Studio网址:

https://lmstudio.ai/

打开网址进入官网下载安装电脑系统对应的客户端:

由于客户端比较大(1个多G),所以安装的时候尽量不要装在C盘,避免占用过多的系统盘内存。

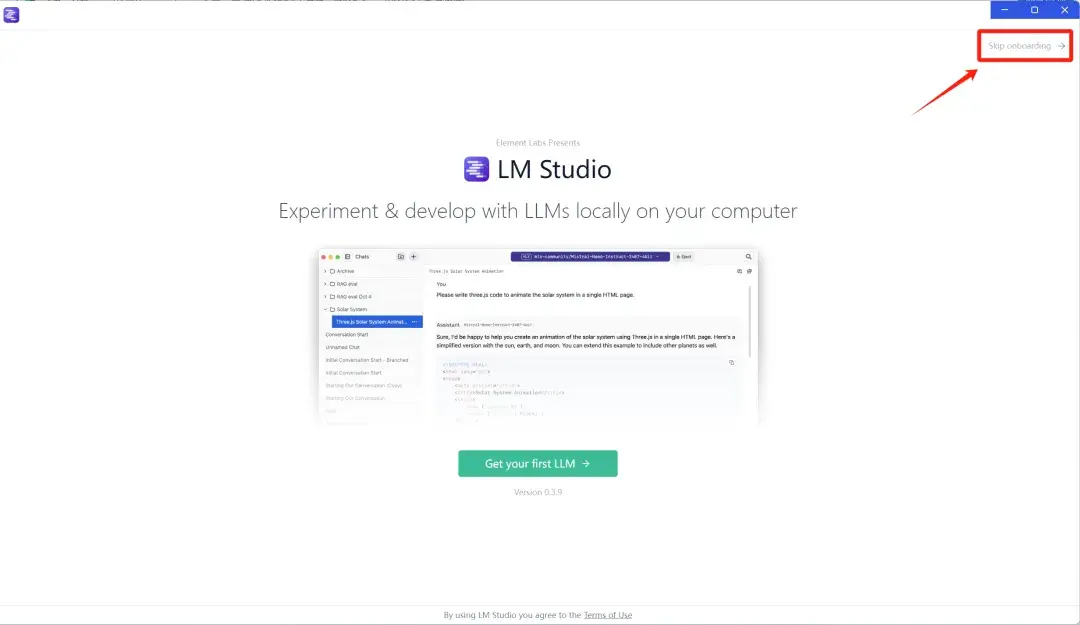

安装完成后运行客户端,首次运行直接点击右上角“Skip onboarding”,跳过引导页:

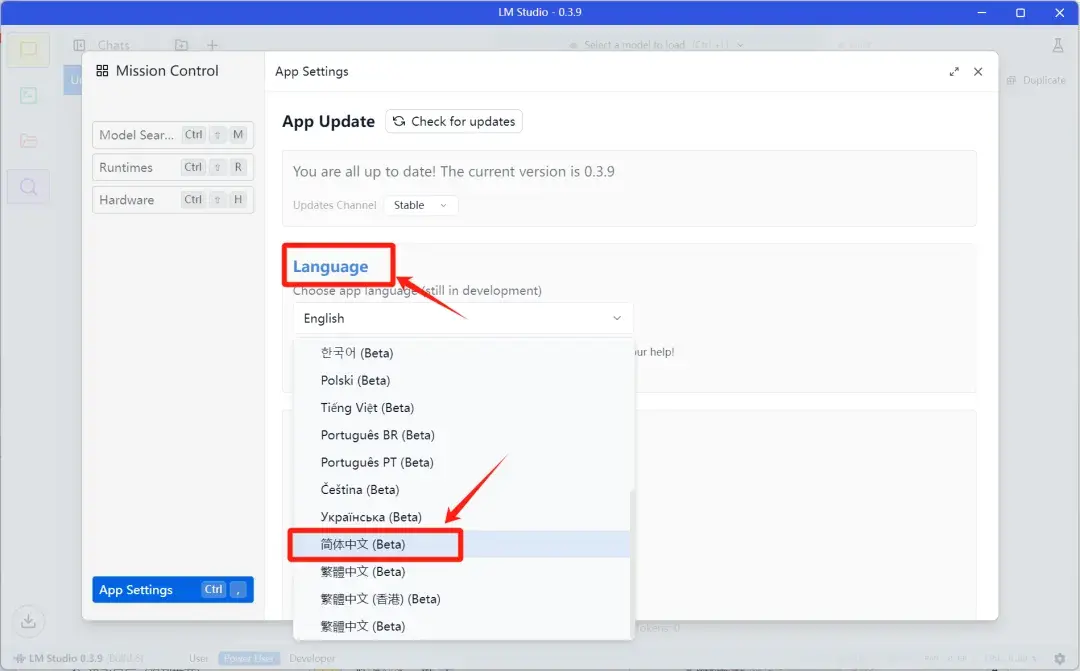

第一次启动LM Studio时,默认界面是纯英文界面,可以点击右下角设置图标进入设置界面切换语言:

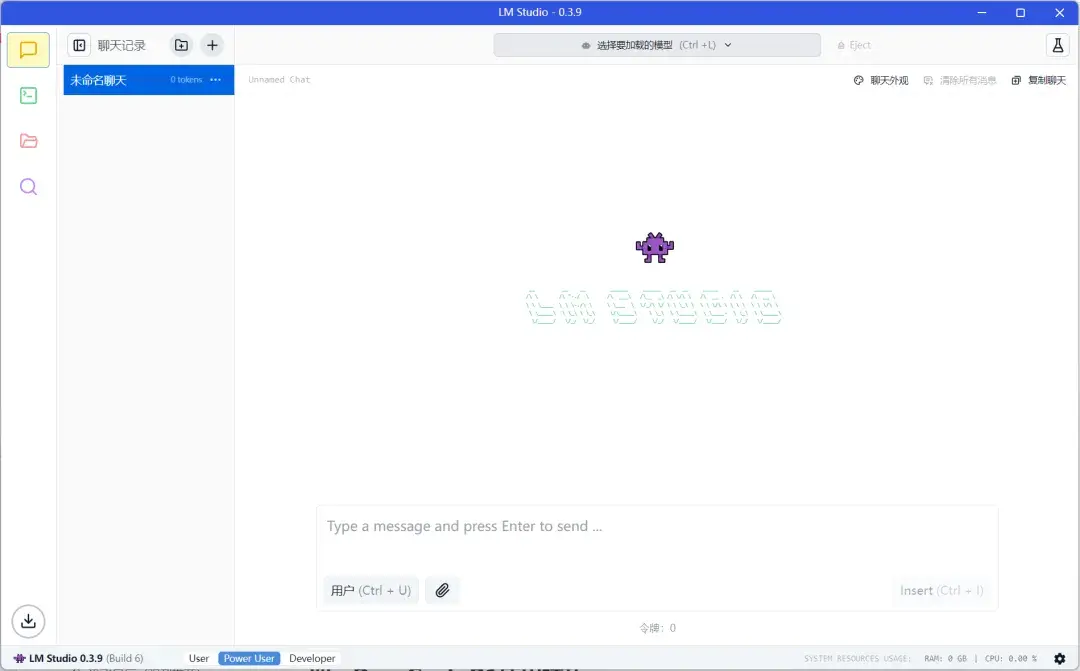

在「Language」选项中切换成简体中文,然后应用就会切换成纯中文界面了。

2)下载大模型

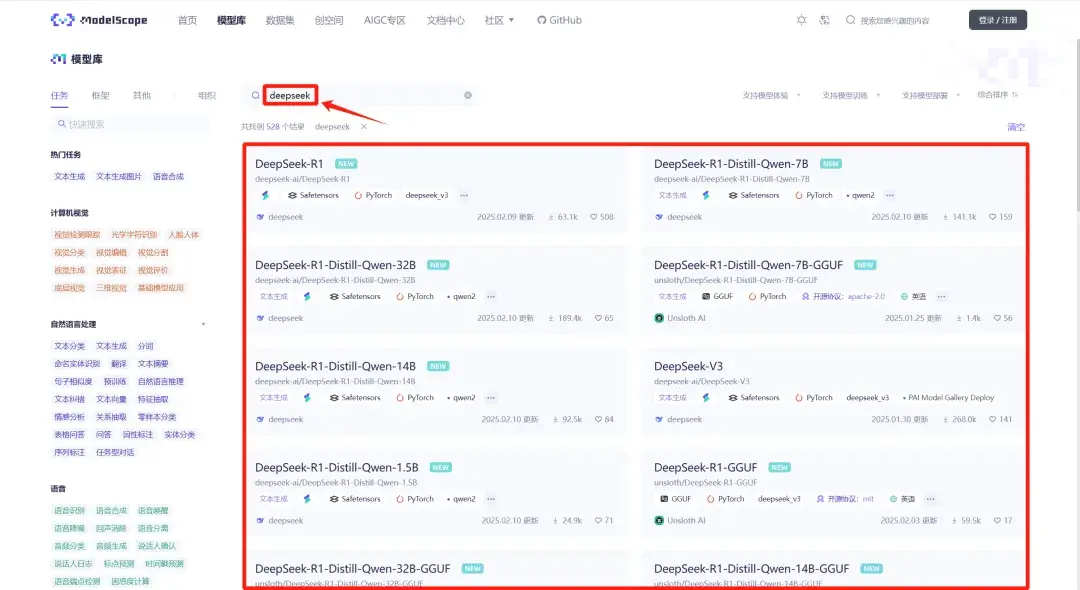

下载地址:

https://modelscope.cn/models

打开网址进入魔塔社区,在模型搜索栏直接搜索DeepSeek,DeepSeek相关的大模型就都筛选出来了:

每个模型又有两个版本,一种是没有量化的原始版本,另一种是GGUF量化模型(后缀带.gguf)。

这里简单解释一下什么是GGUF量化模型,一句话概括:

GGUF量化模型 ≈ 给大模型“瘦身”

就像你手机里的高清照片(原版模型)占内存太大,用微信发图时选择“压缩”(量化),虽然画质降了点,但传得快、手机不卡 —— 这就是量化模型的作用!

把原本需要顶级显卡配置才能运行的大模型,通过“压缩”(量化)变成手机/普通电脑也能用的版本。

所以,如果你的电脑配置不高,建议选择下载GGUF量化模型,虽然会损失一定的精度,但起码可以让大模型在电脑本地跑起来。

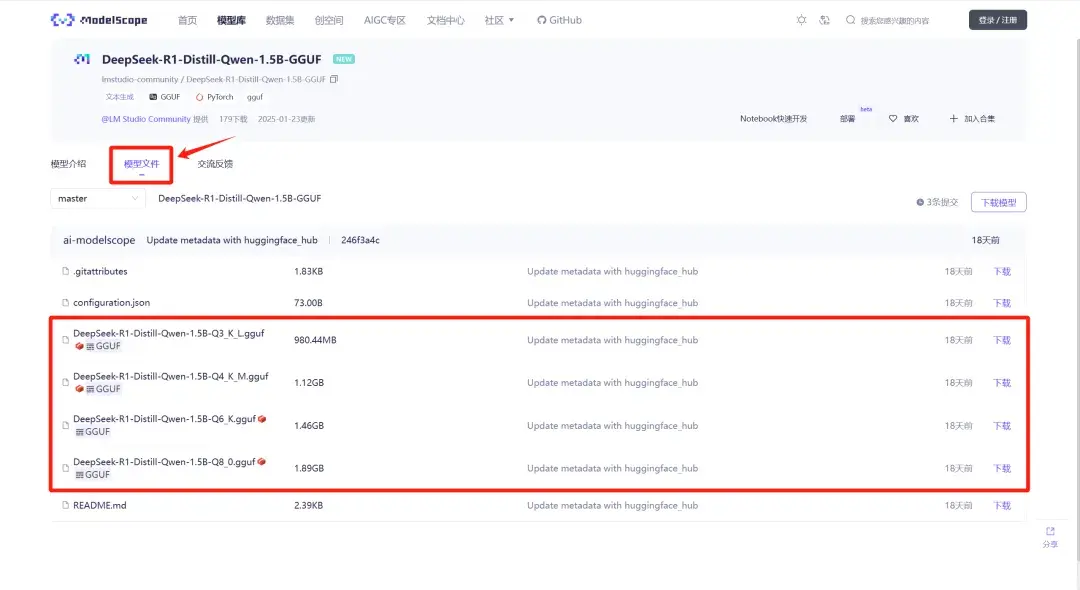

这里以DeepSeek-R1-Distill-Qwen-1.5B-GGUF为例,点开对应的大模型,点击模型文件,就可以看到不同版本的量化模型:

模型名称里的Q3、Q4、Q6、Q8代表的是不同的压缩程度,数字越小表示压缩得越狠,需要的硬件配置要求也越低。

以图片压缩来类比一下大模型的压缩等级参考:

- Q2/Q3:马赛克画质(速度快但容易胡言乱语)

- Q4/Q5:普通照片(速度和质量平衡)

- Q6/Q8:高清无损(接近原版但要求配置高)

根据你自己的电脑配置下载对应的大模型即可。

下载的时候注意,大模型的体积一般都比较大,所以尽量不要放在C盘,最好放在其他的固态盘。

3)导入LM Studio

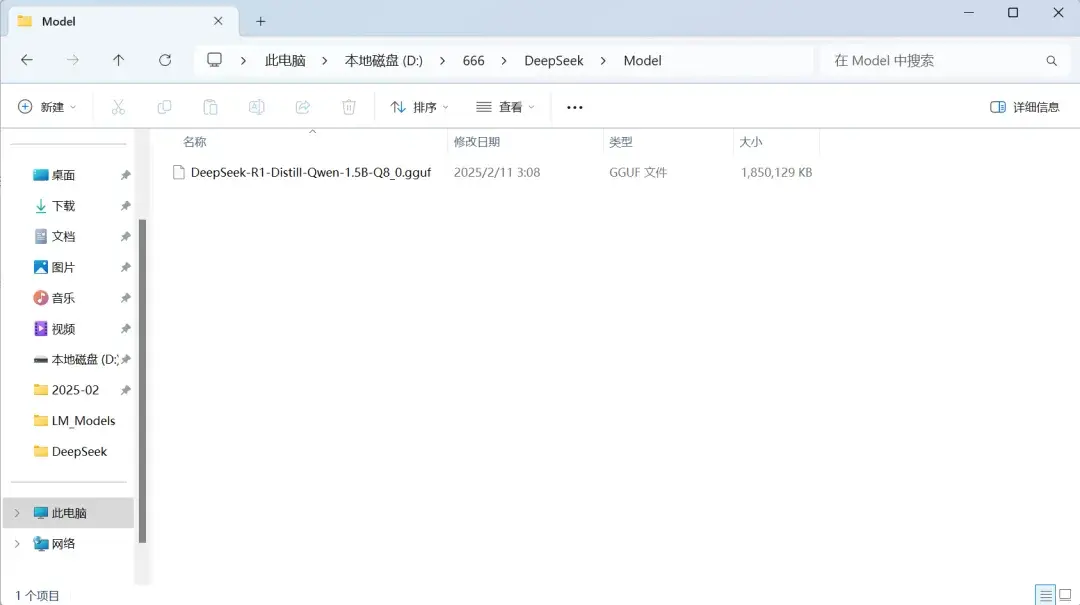

下载好大模型之后,需要把大模型放置在一个三层文件夹下。

比如:

在D盘新建一个“666”文件夹,然后在“666”文件夹下再新建一个“DeepSeek”文件夹,然后在“DeepSeek”文件夹下再新建一个“Model”文件夹

这样就形成了一个三层文件夹:

666/DeepSeek/Model

然后把下载好的大模型移动到Model文件夹下:

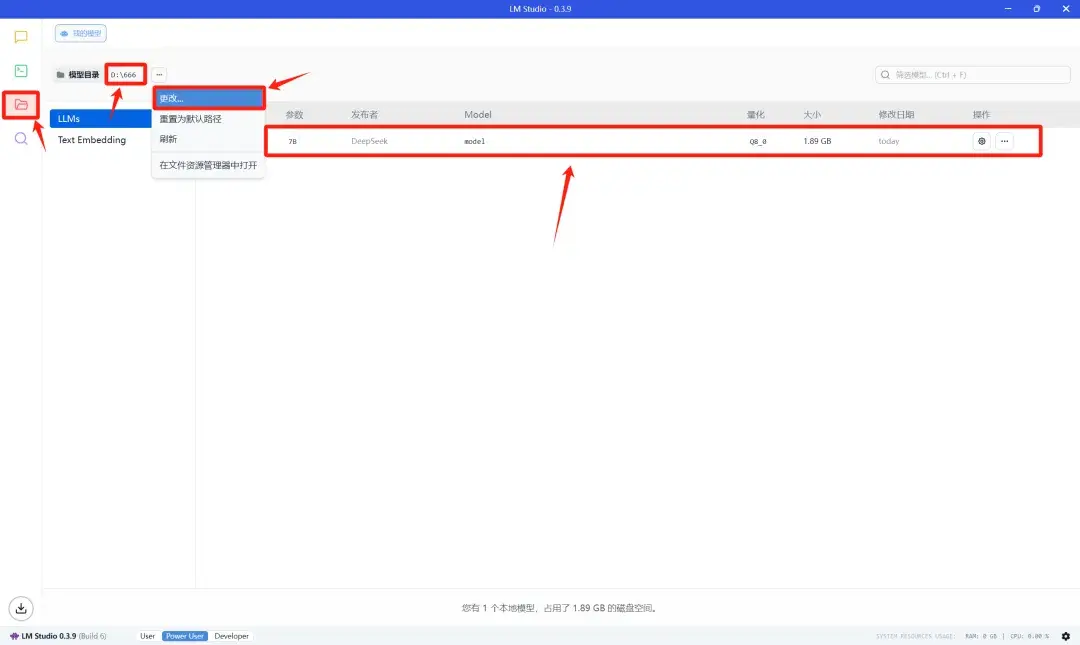

打开LM Studio,点击左侧菜单栏文件夹图标,然后把模型目录更改为最外层的文件夹地址,也就是“666”文件夹。

LM Studio就会自动检测出文件夹下的大模型:

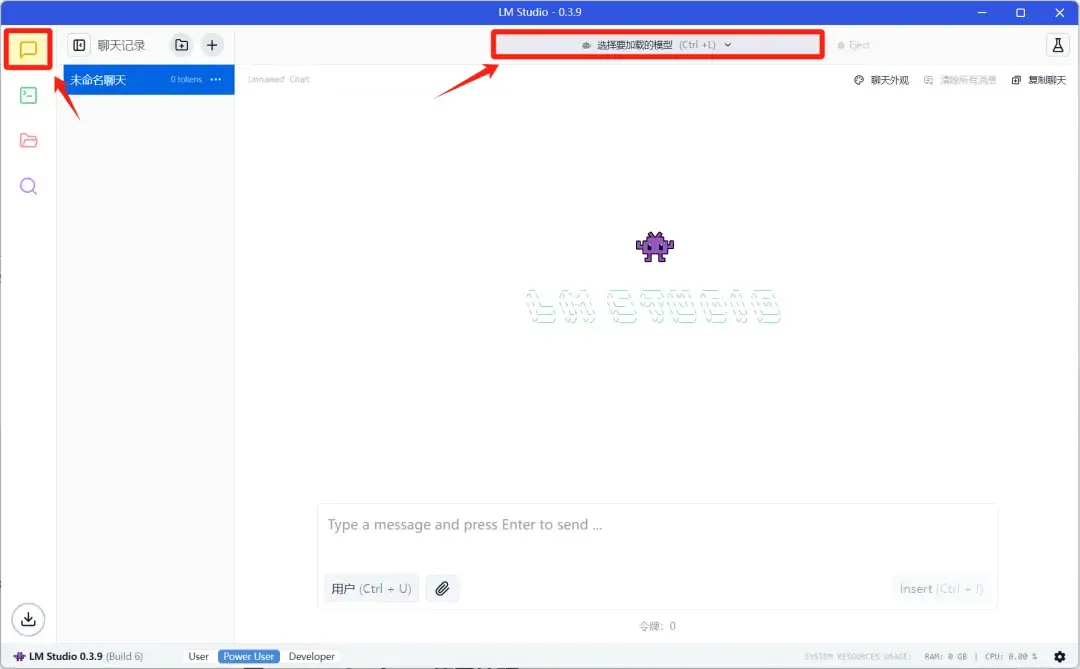

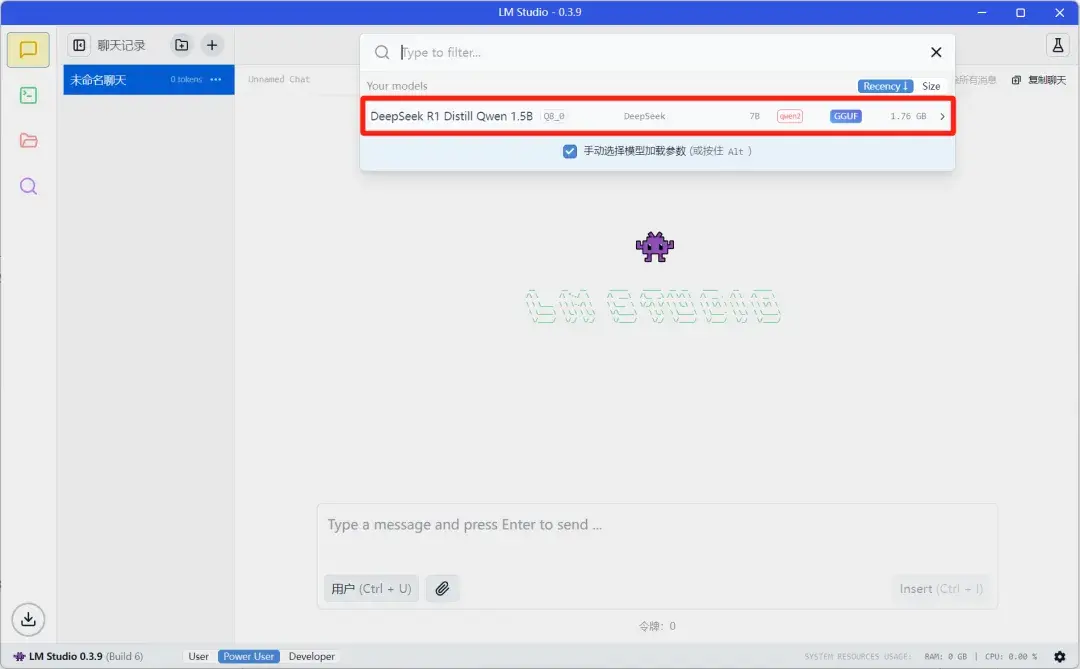

然后回到对话界面,点击上方的模型加载栏:

就可以看到刚才导入的DeepSeek R1 Distill Qwen 1.5B大模型:

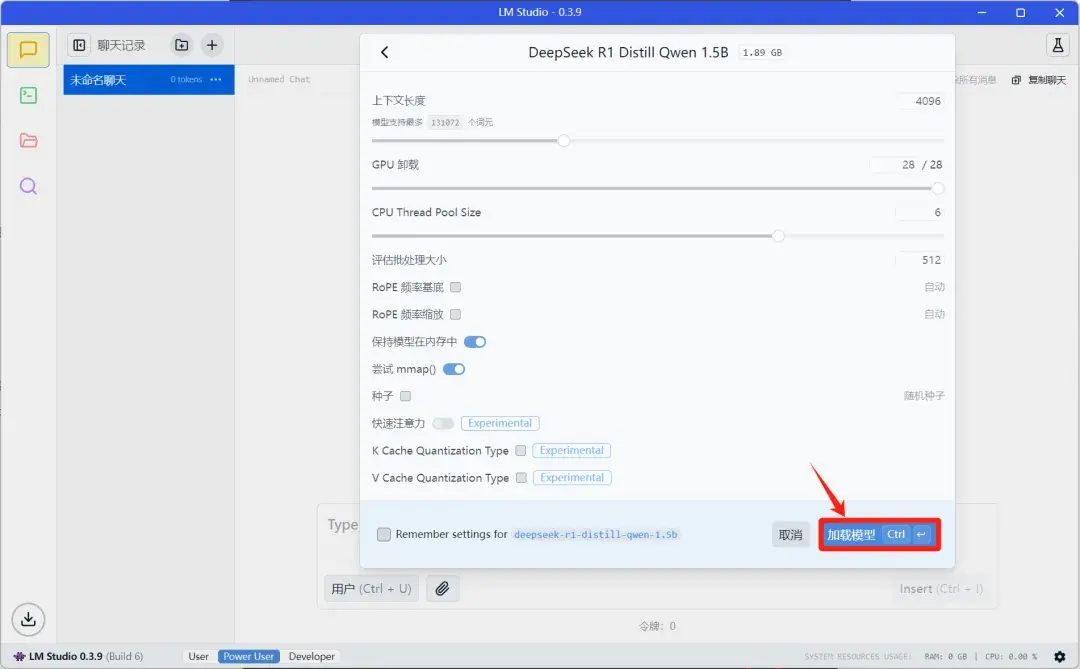

点击大模型就会进入参数设置界面,看不懂的话没关系,直接默认就可以了,然后点击加载模型:

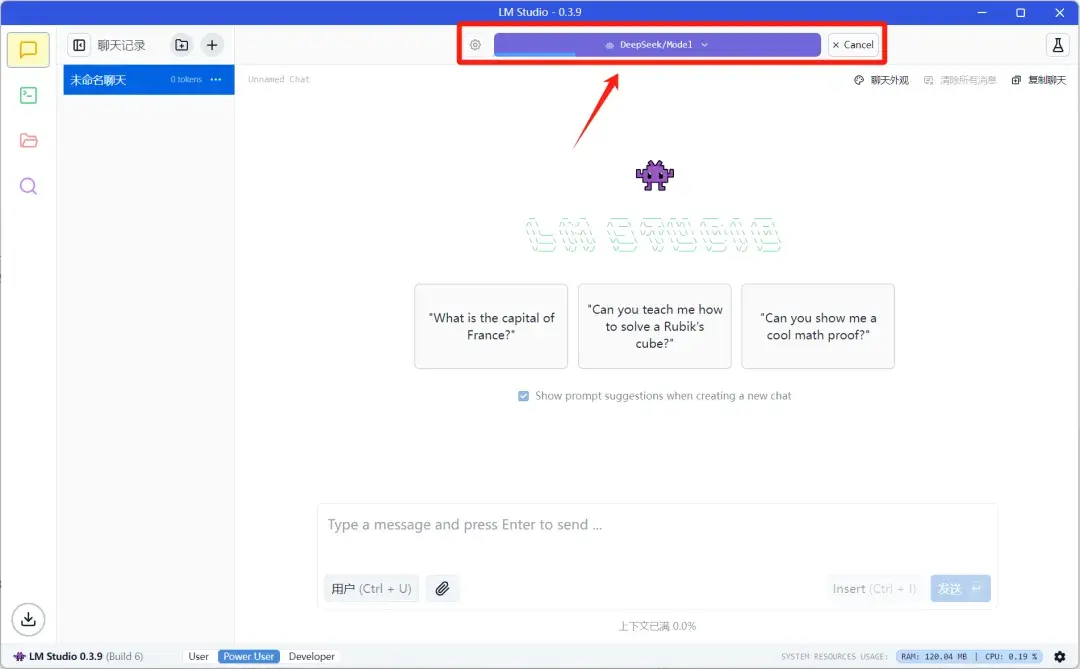

然后LM Studio就会开始加载大模型,等进度条加载完成后大模型就加载好了:

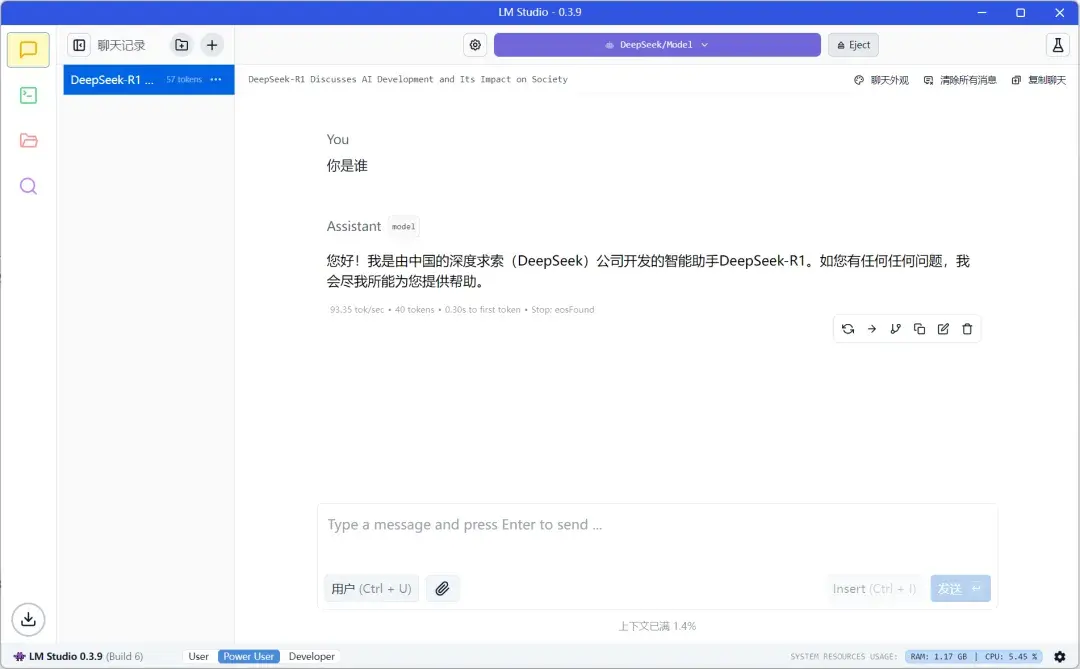

然后就可以在本地使用DeepSeek-R1大模型了:

DeepSeek-R1系列的本地模型运行时同样会显示出来思考过程。

虽然性能和满血版天差地别,但是在同参数体量下的大模型中,DeepSeek-R1系列绝对是性价比最高的大模型。

四、DeepSeek+本地知识库

1)什么是知识库

AI知识库是一种利用人工智能技术(如自然语言处理、机器学习等)整合、存储和管理海量结构化与非结构化知识的智能系统。

它通过知识图谱、本体库等技术实现知识的组织,并具备智能搜索、推理分析和持续学习能力。

其核心在于将分散的信息转化为易于访问和应用的资源,为机器和人类提供高效的知识服务。

2)知识库有什么用

1. 整理知识,避免遗忘

把零散的文档、笔记、经验全塞进一个"智能仓库",需要时秒搜秒回。

比如你记不住公司产品参数,AI知识库能像同事一样张口就答。

对个人来说,相当于把学过的知识系统归档,复习考试或写报告时效率翻倍。

2. 企业提效工具

• 新员工培训不用老员工当复读机,知识库24小时在线教学

• 客服不用背手册,AI自动回答常见问题,并且能用几十种语言服务全球客户

• 技术团队遇到难题时,直接调取历史解决方案,比翻聊天记录快10倍

3. 越用越聪明

本地部署的AI知识库(比如用DeepSeek搭建的)就类似于一个私人智库:

• 数据存在自己电脑里,不用担心泄密

• 专注某个领域(比如医疗或法律),回答比通用AI更精准

• 用久了会自动优化,像老中医越老经验越丰富

• 断网也能用,官方服务器崩了照样工作

4. 跨语言无障碍

中文问英文资料,AI自动翻译解读,比如可以直接用中文查询英文文档。

5. 提升AI专项能力

通过RAG技术(检索增强生成),AI会先翻知识库找线索,再组织语言回答,比纯聊天机器人靠谱得多。比如问"如何处理服务器宕机",它会先检索内部技术文档再生成解决方案。

简单说就是:

个人用能当学习助手,企业用能降本增效,说白了就是让知识“活起来”,随用随取,更高效地解决问题。

(以上内容参考来源:DeepSeek-R1)

3)怎么样使用DeepSeek搭建本地知识库

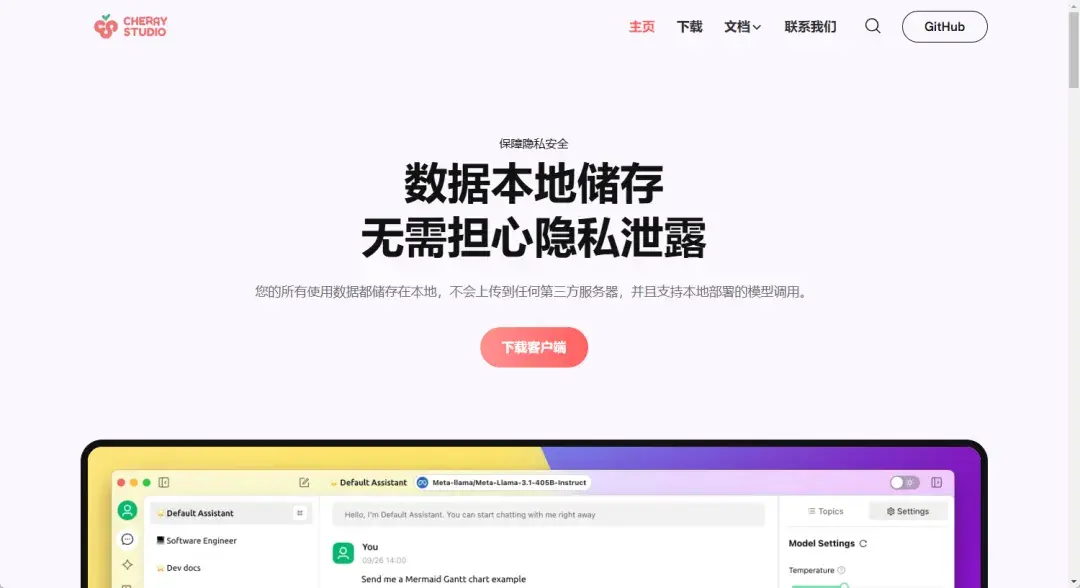

搭建本地知识库这一步我们需要用到的是Cherry Studio这个工具。

Cherry Studio是一款跨平台的桌面工具,聚合了多种主流大语言模型(如OpenAI、DeepSeek、Gemini等),可以通过远程API或本地部署(如Ollama)调用模型。

支持可视化界面,内置300+预配置AI助手,并且提供了相对完整的知识库功能。

Cherry Studio官网:

https://www.cherry-ai.com/

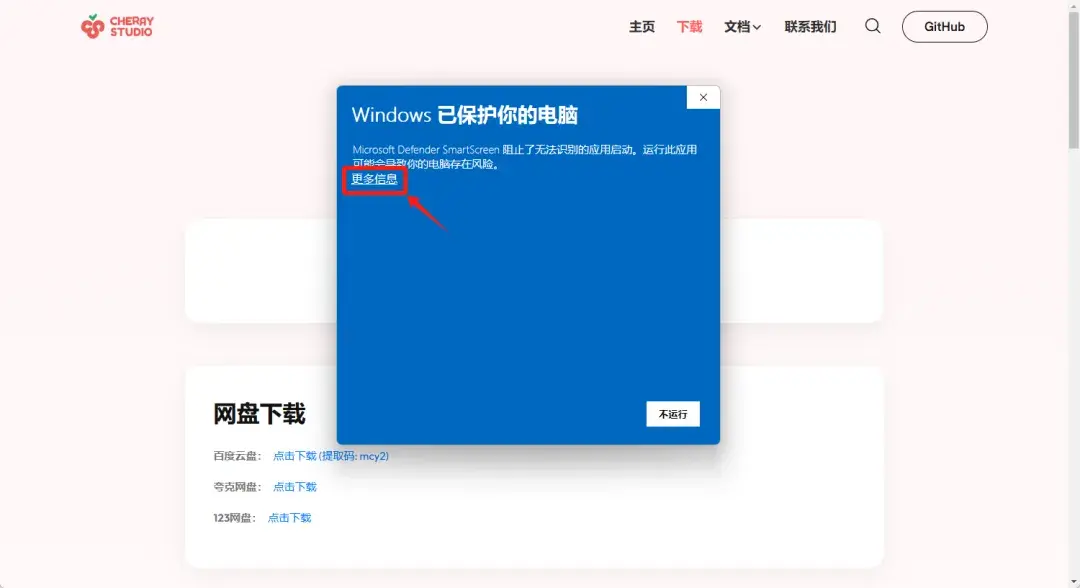

安装比较简单,进入官网下载自己电脑对应的版本,安装的时候如果弹出Windows警告信息,直接点击更多信息:

选择“仍要运行”即可安装:

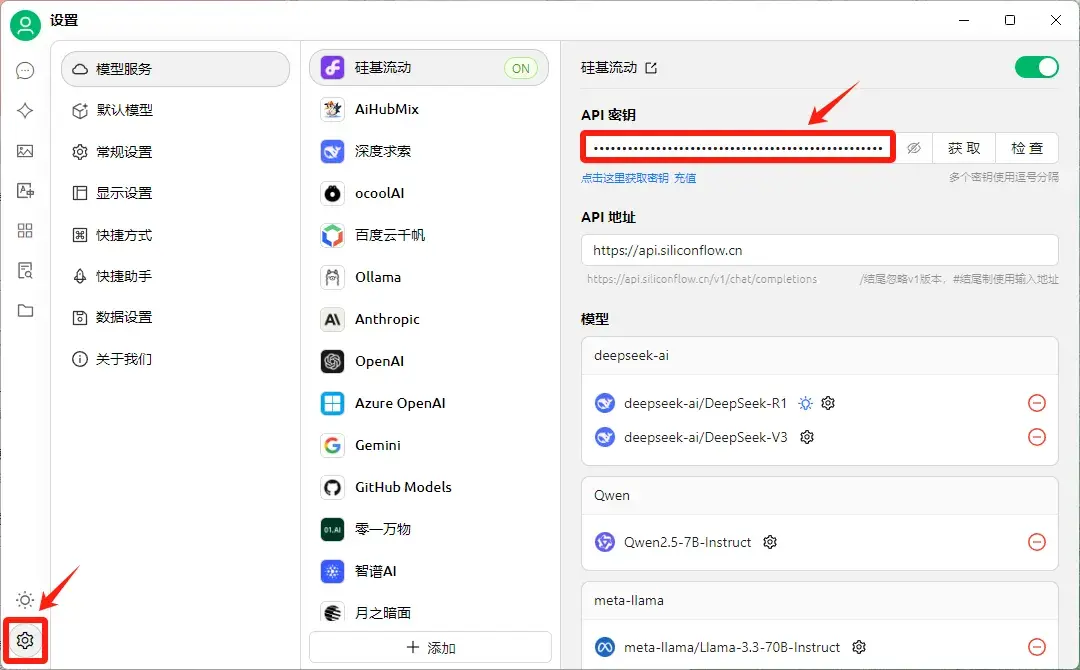

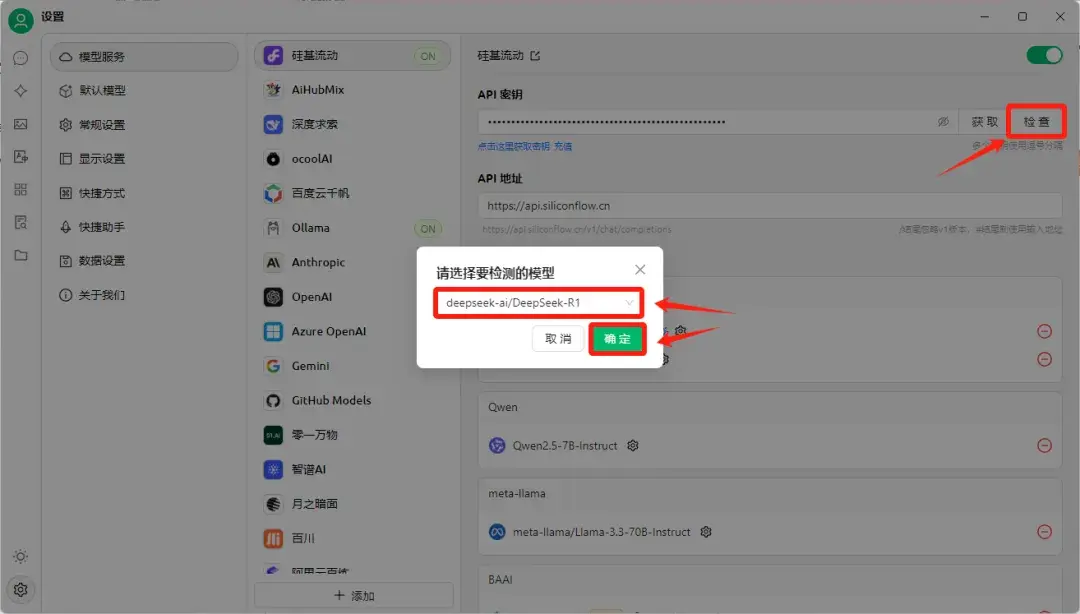

安装好之后点击左下角设置按钮,可以看到Cherry Studio支持的各家云服务,直接把硅基流动里获取的API密钥填写进来就可以。

如果不确定API密钥能不能正常使用,可以点击“检查”,选择想要检测的模型,点击确定,就可以对API进行连接测试:

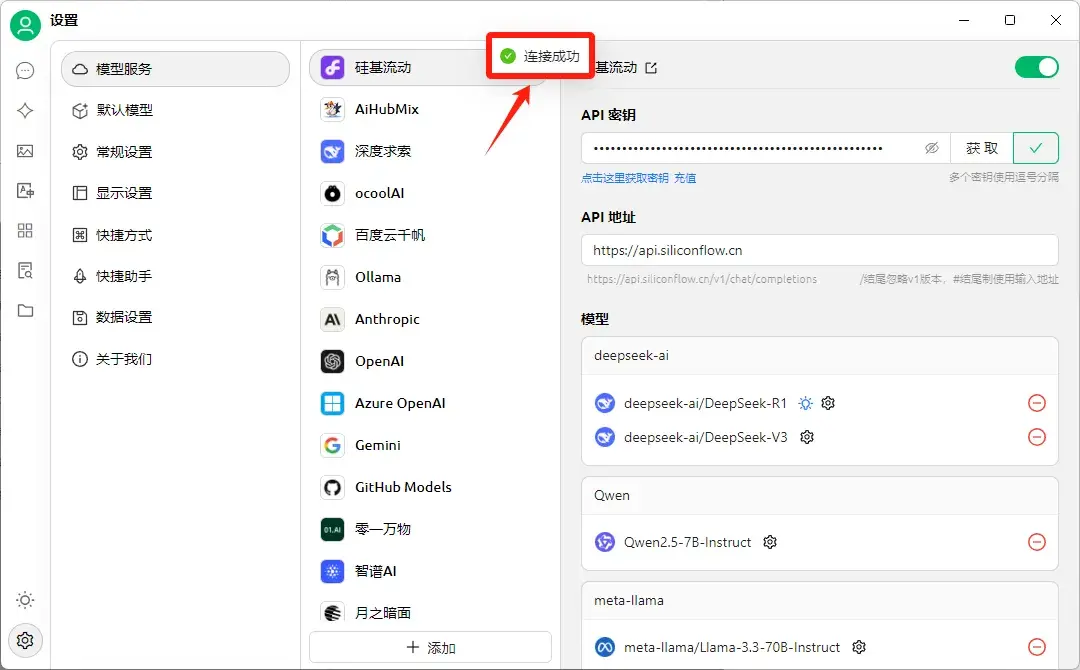

看到界面显示连接成功,就说明API密钥配置成功了!

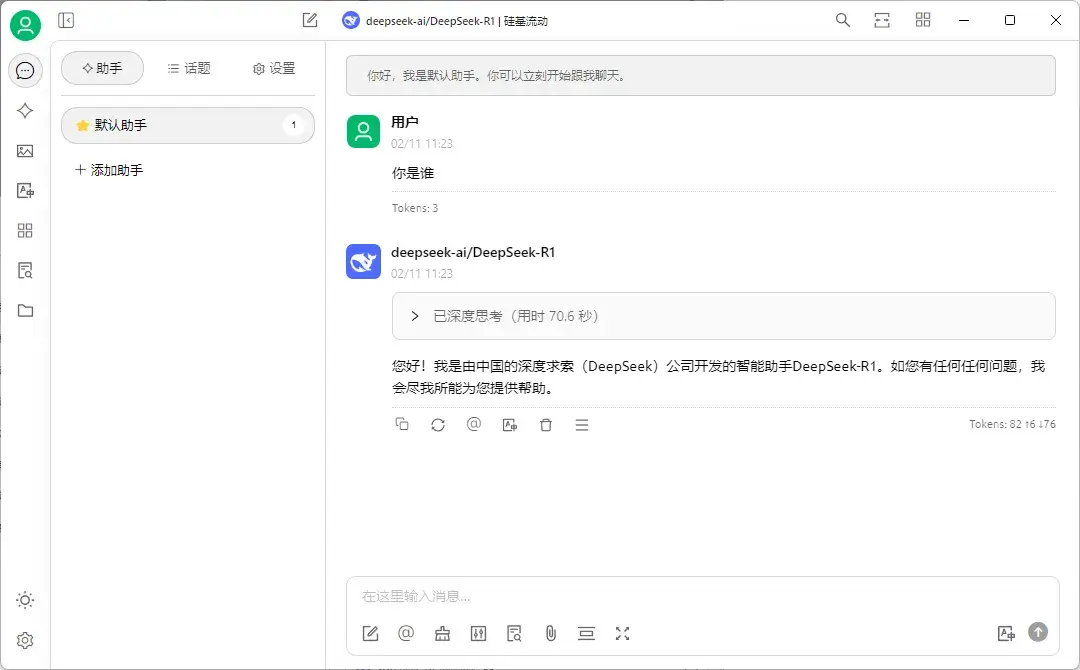

然后回到对话界面,就可以和DeepSeek-R1进行正常对话了。

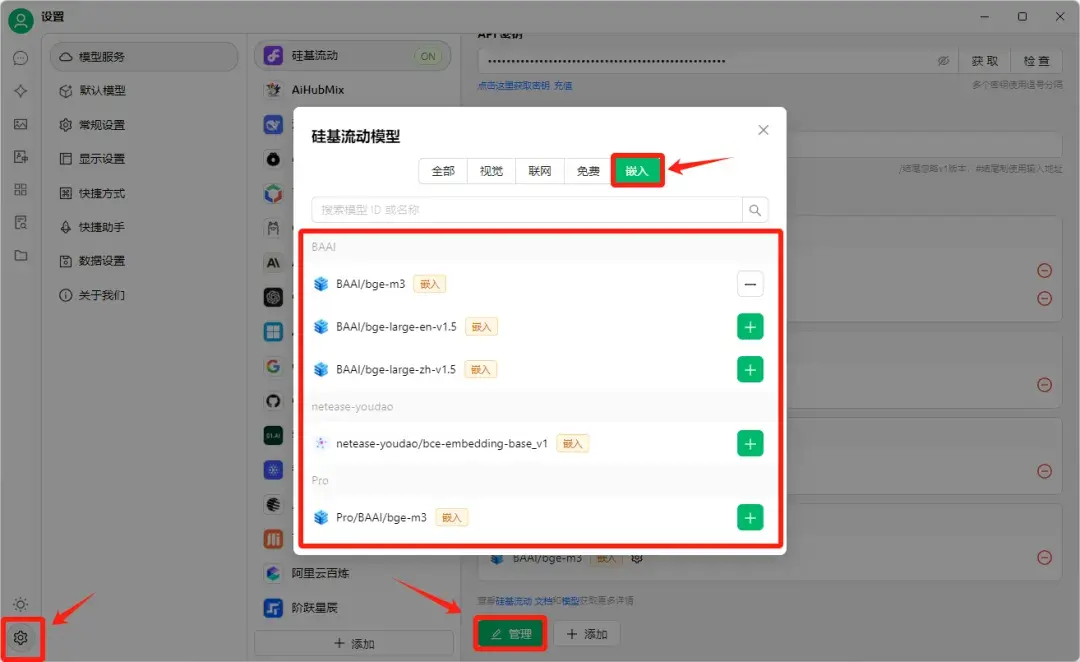

接下来创建本地知识库,点击左侧菜单栏的知识库,选择“添加”,然后输入知识库的名称(自己随便起),选择嵌入模型。

嵌入模型的作用是将复杂数据转换为数值向量,使计算机能够理解和处理。

说白了就是把你的各种文档转换成计算机能够理解的语言,方便计算机处理。

嵌入模型默认选择是BAAI/bge-m3:

也可以在设置界面添加硅基流动支持的其它的嵌入模型:

配置好之后,就可以选择上传你想上传的知识库文档,等待文档上传状态都变成对勾的时候,就说明知识库导入成功了。

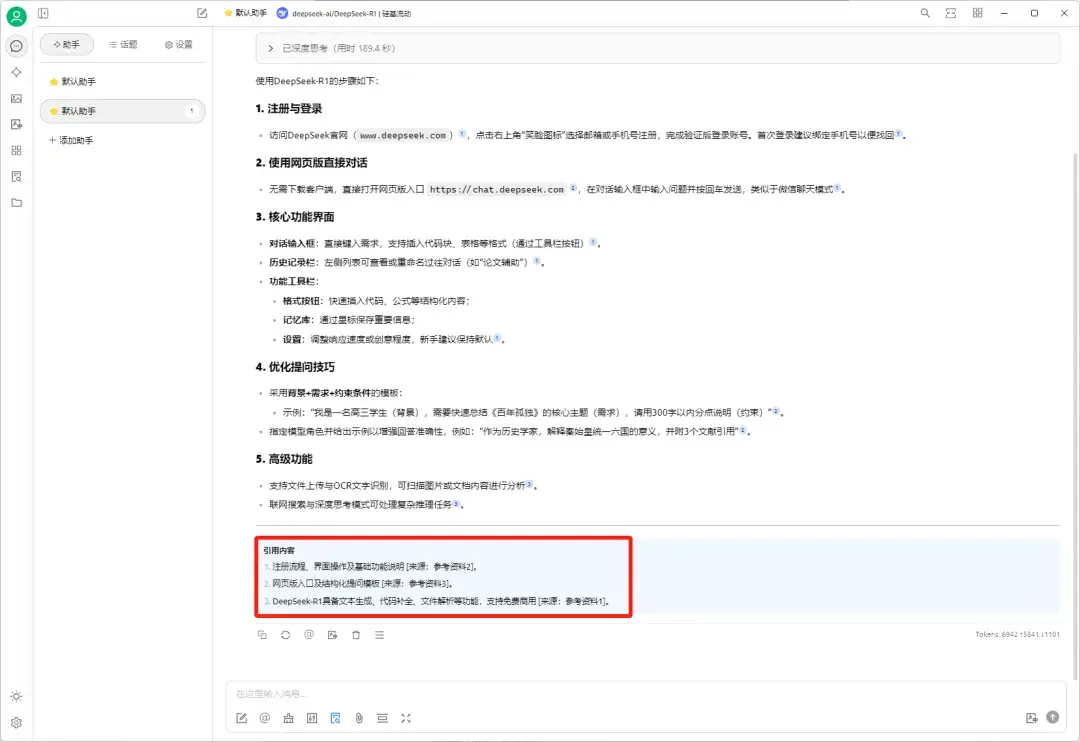

然后回到对话界面,在上方模型栏选择DeepSeek-R1模型,在对话框找到知识库图标,点击选择刚刚创建的知识库:

这样提问的时候DeepSeek-R1就会结合知识库的内容来进行回答,并且还会在回答下方标记引用的知识库文档。

你的知识库内容质量越高,DeepSeek-R1回复的质量就会越高。

以上就是我这两天的折腾总结了。

整体感觉下来,DeepSeek-R1-满血版确实是一款十分强悍的大模型,特别是在处理各种复杂计算、逻辑推理问题方面的表现相当惊艳。

不过不得不说,官网一天总有十几个小时都在各种报错,有时候是真让人头大。

好在硅基流动、讯飞星辰这些平台都提供了免费的 API,而且 API 的稳定性明显要比官网和第三方平台好得多。

现阶段如果想要稳定使用 R1 满血版的话,我觉得最佳方案就是配合 ChatBox 调用 API。

至于本地部署嘛,除非你是真的对技术感兴趣,或者实在不放心数据安全,不然我不建议普通用户折腾。

一来你很难体验到满血版的性能,二来部署过程即使用上面这些工具,对小白用户来说还是有点复杂。

好了,希望这篇文章能帮你少走点弯路。

如果你在使用过程中遇到什么问题,也欢迎留言讨论。